我自己的原文哦~ https://blog.51cto.com/whaosoft/11599989

#关于大模型「越狱」的多种方式

此项目是由伊利诺伊大学香槟分校(UIUC)的汪浩瀚教授主导,汇集了多名intern的共同努力而成。长久以来,这个跨学科的团队一直在前沿科技的浪潮中,致力于推动人工智能的革新,尤其关注于其如何更好地服务于人类社会。在这一宏伟的使命指引下,团队专注于解决两大核心问题:一是确保人工智能的可信赖性与对齐性(Trustworthy and Aligned AI),即如何保证其安全有效地融入人类生活;二是探索人工智能在推动生物医疗领域进步中的潜能和应用(Computational Biology)。

随着人工智能(AI)技术的迅猛发展,特别是大语言模型(LLMs)如 GPT-4 和视觉语言模型(VLMs)如 CLIP 和 DALL-E,这些模型在多个技术领域取得了显著的进展。LLMs 已经在自然语言处理任务中展现出了前所未有的能力,而 VLMs 则在图像和文本的融合任务中表现优异。这些技术的应用范围从自动化客服到智能创作,无不展示出其强大的潜力。然而,伴随着这些进展,安全性和伦理对齐的问题也日益凸显。

近年来,越来越多的研究者关注 LLMs 和 VLMs 的越狱现象,即通过特定技术手段绕过这些模型的内置安全机制,生成不符合伦理规范的输出。这些越狱行为不仅对模型的实际应用构成威胁,也对用户的安全和隐私带来潜在风险。因此,理解和防范这些越狱行为成为 AI 安全研究中的一个关键问题。

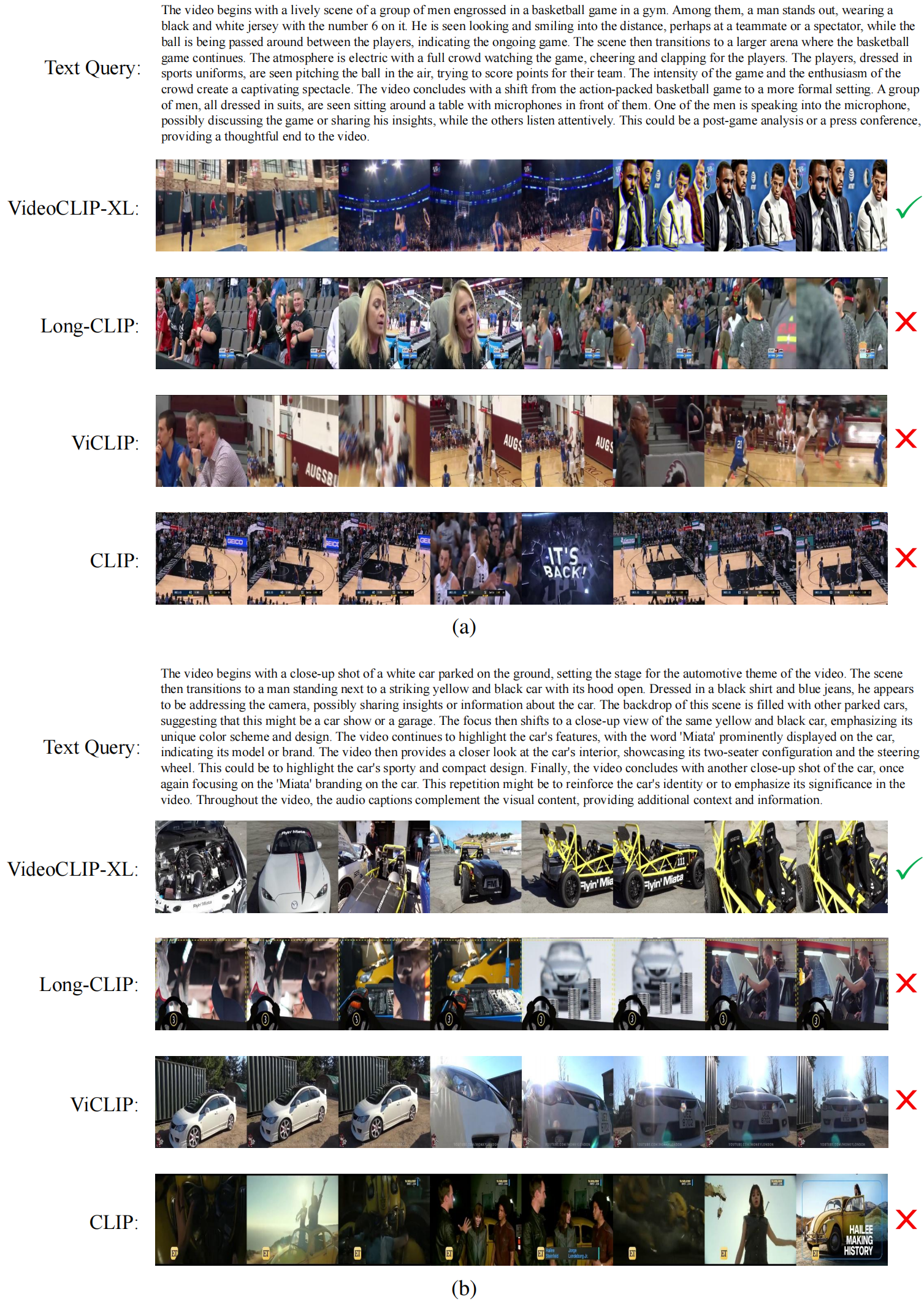

我们来看一个具体的关于越狱的例子:

在上述例子中,用户输入一个恶意问题(蓝色所示),通常而言,大语言模型会拒绝回答此类问题。然而,当攻击者增加一个精心制作的越狱前缀(黄色所示),大语言模型将会对恶意问题进行详细的解答。同样,防御者可以通过增加一些安全提示(红色所示),提醒大语言模型重新思考所给出的答案,中止恶意回复。

针对上述越狱现象,近期,来自伊利诺伊大学香槟分校,布朗大学,密歇根大学安娜堡分校,香港科技大学,卡内基梅隆大学和博伊西州立大学的研究者联合发布了一篇综述,详细探讨了 LLMs 和 VLMs 的越狱现象,对各种越狱类型和相应的防御机制进行了系统分类和分析。通过对现有研究的全面综述,旨在为学术界和工业界提供一个关于 AI 模型安全性的全面视角,并提出应对这些挑战的有效策略。

- 论文地址:https://arxiv.org/pdf/2407.01599

- 项目地址:https://github.com/Allen-piexl/JailbreakZoo

- 网站地址:https://chonghan-chen.com/llm-jailbreak-zoo-survey/

这篇综述提供了:

1. 越狱分类:我们将关于LLMs的越狱现象细分为5种类型,将关于VLMs的越狱现象细分为3种类型,提供了每种类型的详细分类和理解。以下是我们分类的主要内容:

LLMs

- 梯度攻击(Gradient-based Attacks)

- 进化攻击(Evolutionary-based Attacks)

- 演示攻击(Demonstration-based Attacks)

- 规则攻击(Rule-based Attacks)

- 多代理攻击(Multi-agent-based Attacks)

VLMs

- 提示到图像注入的越狱攻击(Prompt-to-Image Injection Jailbreaks)

- 提示-图像扰动注入越狱攻击(Prompt-Image Perturbation Injection Jailbreaks)

- 代理模型迁移越狱攻击(Proxy Model Transfer Jailbreaks)

此外,我们进一步整理了现有的利用越狱攻击对LLMs和VLMs进行评测的方法,以及一些相关的综述。

2. 防御机制:我们回顾并分类了各种防御策略,我们发现,LLMs和VLMs有着类似的防御机制,强调了统一方法以应对这些越狱漏洞的必要性。主要防御机制包括:

- 提示检测(Prompt Detection-based Defenses)

- 提示扰动(Prompt Perturbation-based Defenses)

- 演示防御(Demonstration-based Defenses)

- 生成干预(Generation Intervention-based Defenses)

- 响应评估(Response Evaluation-based Defenses)

- 模型微调(Model Fine-tuning-based Defenses)

3. 未来研究方向:我们的综述突出了当前研究中的关键空白,并提出了未来的研究方向,以增强LLMs和VLMs的安全框架。

越狱类型及实例 - 大语言模型(LLMs)

在我们的研究中,我们将大语言模的越狱现象进行了系统分类,归纳为七种主要类型。每种类型都有其独特的攻击方法和技术细节,通过对这些越狱类型的深入分析,我们希望能够揭示这些模型在安全性方面的潜在漏洞,并为未来的防御工作提供指导。

1. 梯度攻击(Gradient-based Attacks)

梯度攻击通过利用模型的梯度信息,生成有害响应。例如,使用梯度坐标贪婪算法(GCG)生成后缀,使模型生成有害内容。此方法通过梯度优化生成能避开模型检测的提示,从而使 LLM 输出有害的响应。此类攻击常用于测试模型的安全性和鲁棒性,研究者通过此类攻击可以发现模型的潜在漏洞,并进行相应的修复和优化。

2. 进化攻击(Evolutionary-based Attacks)

进化攻击使用遗传算法生成对抗性提示,优化语义相似性、攻击效果和流畅性。例如,FuzzLLM 通过随机组合模板、约束和问题集生成攻击指令。这些方法使用进化策略逐步改进提示,以找到最有效的攻击手段。进化攻击特别适合在黑盒环境中使用,即攻击者对模型内部结构和参数未知的情况下,也能进行有效攻击。

3. 演示攻击(Demonstration-based Attacks)

演示攻击通过创建特定的系统提示,指示 LLMs 生成预期的响应。这些方法通常是硬编码的,提示经过精心设计以引导模型生成所需的响应。例如,DAN 方法通过预设的对话框架,使模型在 “开发者模式” 下生成本不应生成的内容。演示攻击利用模型的上下文学习能力,通过提供一系列示例,使模型更容易产生目标响应。

4. 规则攻击(Rule-based Attacks)

规则攻击通过预定义的规则将恶意成分分解并重定向。攻击者设计复杂的规则,隐藏恶意内容。例如,通过词汇替换将有害意图编码为看似正常的内容,从而绕过模型的检测。这类攻击方法特别适用于绕过简单的基于关键字的检测系统,使攻击内容在输入时显得无害。

5. 多代理攻击(Multi-agent-based Attacks)

多代理攻击利用多个 LLMs 合作,生成、组织和改进越狱提示。这些方法通过模拟多模型协作的方式,提高越狱攻击的效果。例如,PAIR 方法利用多个代理模型生成和评估提示,不断优化攻击策略。这种方法特别适合用于需要迭代改进的攻击场景,通过多次尝试和反馈,找到最有效的攻击手段。

越狱类型及实例 – 视觉语言模型(VLMs)

与大语言模型(LLM)类似,与视觉语言模型(VLM)相关的越狱也已成为一个重要关注点。由于所有 VLM 都使用 LLM 组件进行文本编码,因此影响 LLM 的漏洞也可能会危及 VLM。此外,VLM 中视觉输入的引入不仅拓宽了其功能范围,还显著增加了攻击面,从而加剧了涉及的安全风险。与主要针对文本输入的 LLM 越狱不同,VLM 的恶意操纵可以通过视觉输入、文本组件或两者的组合进行,表现出更加复杂和多样的模式。

1. 提示到图像注入的越狱攻击(Prompt-to-Image Injection Jailbreaks)

通过将恶意提示注入到图像生成过程中来绕过模型的安全机制。攻击者设计特定的文本提示,使模型生成含有不良或不符合伦理的图像。例如,攻击者可以利用一些敏感词汇或语句来引导模型生成攻击性或误导性的图像。

2. 提示 - 图像扰动注入越狱攻击(Prompt-Image Perturbation Injection Jailbreaks)

提示 - 图像扰动注入越狱攻击结合了文本提示和图像扰动,通过在输入提示中加入微小的扰动,使模型生成错误或有害的响应。例如,攻击者可以在图像中加入几乎不可见的像素变化,同时调整文本提示,以引导模型生成偏离预期的描述或内容。这种方法利用了模型对微小变化的敏感性,使其难以检测和防御。

3. 代理模型迁移越狱攻击(Proxy Model Transfer Jailbreaks)

代理模型迁移越狱攻击利用代理模型进行攻击,即在较小的代理模型上训练和优化攻击,然后将其转移到目标模型上。攻击者在代理模型上进行大量试验,找到有效的攻击方式,再将这些攻击应用到目标模型上。此类攻击可以有效绕过目标模型的安全机制,因为代理模型和目标模型可能共享相似的弱点和漏洞。

防御机制及实例 - 大语言模型(LLMs)

1. 提示检测(Prompt Detection-based Defenses)

提示检测基于输入提示的特征,如困惑度(Perplexity)和长度,评估提示的有害性。例如,通过困惑度计算器 LLM 检测输入提示的困惑度,判断其是否安全。提示检测是最早的防御策略之一,利用模型对高困惑度提示的不敏感性来判断提示的安全性。

2. 提示扰动(Prompt Perturbation-based Defenses)

提示扰动通过对输入提示进行修改,破坏其恶意意图。例如,通过语义扰动和重新分词技术生成多个变体,评估每个变体的响应是否安全。此类方法利用了恶意提示对精确结构和词序的依赖,通过随机扰动破坏这些结构,使其难以成功执行攻击。

3. 演示防御(Demonstration-based Defenses)

演示防御通过设置安全的系统提示,引导 LLM 生成安全响应。例如,使用自我提醒提示模型生成安全的响应。演示防御利用了模型的上下文学习能力,通过提供正面示例,增强模型对安全响应的倾向。

4. 生成干预(Generation Intervention-based Defenses)

生成干预通过调整 LLM 的响应生成过程,确保输出的安全性。例如,RAIN 方法通过反复生成和评估 token,确保生成的内容安全。此类方法在生成过程中实时干预,动态调整输出内容,以避免生成有害响应。

5. 响应评估(Response Evaluation-based Defenses)

响应评估通过对生成的响应进行评估,确保其安全性。例如,利用辅助 LLM 评估响应的有害性,并进行迭代改进。此类方法利用模型对自身生成内容的评估能力,通过不断优化,确保最终输出的安全。

6. 模型微调(Model Fine-tuning-based Defenses)

模型微调通过调整 LLM 的内部参数,增强其安全性。例如,通过在混合数据上训练模型,使其对有害内容更加敏感,从而生成更安全的响应。此类方法直接改变模型的行为,使其在面对恶意提示时能够做出更安全的决策。

防御机制及实例 – 视觉语言模型(VLMs)

在视觉语言模型中,许多防御策略与大语言模型的防御策略相似。这些策略通过调整模型的内部参数、评估生成的响应以及扰动输入提示来增强模型的安全性。

1. 提示扰动防御(Prompt Perturbation-based Defenses)

提示扰动通过对输入提示进行修改,破坏其恶意意图。例如,通过语义扰动和重新分词技术生成多个变体,评估每个变体的响应是否安全。此类方法利用了恶意提示对精确结构和词序的依赖,通过随机扰动破坏这些结构,使其难以成功执行攻击。

2. 响应评估防御(Response Evaluation-based Defenses)

响应评估通过对生成的响应进行评估,确保其安全性。例如,利用辅助 VLM 评估响应的有害性,并进行迭代改进。此类方法利用模型对自身生成内容的评估能力,通过不断优化,确保最终输出的安全。

3. 模型微调防御(Model Fine-tuning-based Defenses)

模型微调通过调整 VLM 的内部参数,增强其安全性。例如,通过在混合数据上训练模型,使其对有害内容更加敏感,从而生成更安全的响应。此类方法直接改变模型的行为,使其在面对恶意提示时能够做出更安全的决策。

未来研究方向

我们的研究不仅分析了当前 LLMs 和 VLMs 越狱现象及其防御机制,还发现了现有研究中的一些关键空白。这些空白为未来的研究提供了重要的方向,以进一步增强 AI 模型的安全性和鲁棒性。以下是我们提出的几个未来研究方向:

1. 多模态越狱攻击与防御

随着多模态 AI 系统的快速发展,如何在结合文本和图像的环境中进行越狱攻击并有效防御成为一个重要课题。未来研究应重点关注多模态模型中的越狱技术,包括如何利用视觉和文本输入的协同作用来规避安全机制。同时,需要开发专门针对多模态系统的防御策略,以确保这些系统在处理复杂任务时的安全性。

2. 自动化越狱检测与修复

现有的越狱检测方法大多依赖于手工设计的规则和特征,效率较低且难以适应不断变化的攻击手段。未来研究可以探索利用机器学习和深度学习技术,开发自动化的越狱检测与修复系统。这些系统应能够实时检测并修复潜在的越狱攻击,提升模型的自我保护能力。

3. 强化学习在越狱防御中的应用

强化学习(Reinforcement Learning, RL)在越狱防御中的应用具有广阔前景。通过 RL,模型可以在不断的交互中学习如何识别和防御越狱攻击。例如,利用 RL 技术,模型可以动态调整其内部参数和响应策略,以应对不同类型的攻击。未来研究应深入探索 RL 在越狱防御中的应用,并开发相应的算法和工具。

4. 越狱攻击的伦理与法律研究

随着越狱技术的不断发展,其潜在的伦理和法律问题也逐渐显现。未来研究应关注越狱攻击的伦理和法律影响,包括如何制定相关法规和政策来规范越狱行为。此外,还需要探索如何在技术和法律层面有效平衡创新与安全,确保 AI 技术的可持续发展。

5. 开放与封闭模型的安全对比研究

当前的研究多集中于开放源代码的模型,而对封闭源代码模型的研究相对较少。未来应更多关注开放与封闭模型在安全性方面的差异,研究如何在封闭环境中实现高效的安全防御。同时,还需探索开放模型社区的协作机制,以共享和推广有效的防御策略。

6. 用户教育与防护

除了技术层面的防御,用户教育也是防范越狱攻击的重要环节。未来研究应开发针对不同用户群体的教育资源,提高用户对越狱攻击的认知和防范能力。通过增强用户的安全意识,可以有效减少越狱攻击的成功率,从而提升整体系统的安全性。

总结

大语言模型(LLMs)和视觉语言模型(VLMs)的越狱现象和防御机制有许多共性和差异。共性源于它们都基于深度学习技术和类似的神经网络结构,且主要处理自然语言内容,因此在面临梯度攻击、进化攻击等威胁时表现出相似的脆弱性。防御策略如提示检测、提示扰动、生成干预、响应评估和模型微调在两者中也有广泛应用。然而,VLMs 由于需要处理图像和文本的组合输入,其攻击手段更为复杂,包括 Prompt-to-Image Injection 和 Prompt-Image Perturbation Injection 等多模态攻击。防御机制也因此更复杂,需要同时考虑视觉和语言输入的特性。VLMs 的训练成本较高,Proxy Model Transfer Jailbreaks 在这种情况下更为常见,攻击者利用代理模型优化攻击,再将其应用于目标模型。此外,LLMs 和 VLMs 在应用场景上有所不同,LLMs 主要用于文本生成和对话系统,而 VLMs 则用于图像生成和图文理解任务。这些共性和差异为理解和应对 AI 模型的安全威胁提供了重要的洞见,未来研究应继续关注这些方面,以开发更有效的防御策略,确保 AI 技术的安全应用。

#AMD召回所有新一代CPU

因为有 typo,召回所有已铺货芯片。

上个月,AMD 首席执行官苏姿丰博士在 ComputeX 开幕主题演讲上揭开了 Zen 5 架构的神秘面纱。作为 AMD 未来几年 CPU 的台柱子,Zen 5 立刻被引入消费级市场,面向笔记本和台式机的产品在几周内相继发布。

然而临近上市日期,AMD 突然宣布,由于「对 Ryzen 9000 系列处理器的包装产品测试流程」存在问题,其将推迟数周推出搭载 Zen 5 的 Ryzen 9000 处理器。由于最近英特尔酷睿芯片曝出问题,人们对高端芯片质量的关注度很高,AMD 的这一消息让人不禁怀疑:难道现在苏妈也不靠谱了?

随着信息逐步披露,事情逐渐变得让人忍俊不禁:一张贴错标签的 Ryzen 处理器的新图片暗示了 AMD 推迟推出芯片的主要原因之一 —— 一个简单的一位数字拼写错误。

昨天在 B 站上发布的一个提前泄露测试结果显示,AMD 的 Ryzen 7 9700X 被错误标记为 Ryzen 9 9700X 处理器,这是一个明显的错误,需要纠正。

视频发布后,tomsHardware 等海外媒体已经确认了 9700X 是错误标记,并且还了解到,贴错标签的 Ryzen 5 9600X 型号也已运往零售店 —— 这些处理器也被标记为 Ryzen 9。

我们现在可以合理地假设 AMD 零售包装盒上的标签可能也有问题。无论存在哪种情况,这似乎只是一个小问题,不过 AMD 显然必须召回所有已发货的处理器,以纠正错误的标记。

召回芯片的过程正是该公司所说的推迟其处理器发布的原因 ——AMD 表示,已经召回了所有交付给全球零售商和 OEM 的 Ryzen 9000 单元进行重新筛选,这些受影响的芯片将在筛选过程后退还给零售商。不过,AMD 尚未说明召回的具体原因。值得注意的是,「silkscreening」是行业术语,指的是芯片封装过程中,涉及激光蚀刻或打印芯片顶部标记的过程。AMD 明确指出需要进行「重新筛选」过程来解决其未定义的问题,但并未明确将其称为「silkscreening」。

AMD 在上周发布的声明中表示:「在最终检测中,我们发现首批产品并未完全达到预期的质量标准。」这表明,包装上的字印错了,可能并不是 AMD 延迟发售的唯一原因。

AMD 高级副总裁,计算和图形总经理 Jack Huynh 在 X 平台上表示:Ryzen 9000 系列处理器因质量问题将延迟上架。

根据 Jack Huynh 的发言,也引申出了另一个版本的故事:AMD 透露这次事件并不是 CPU 微架构的问题,因此不需重新设计或重新制造 Ryzen 9000 芯片,也不需改变已经定义的各型号规格。问题出在封装测试的流程,导致筛选过程中可能会令不良品通过测试。这次的延迟是出于谨慎考虑,旨在保证每个 Ryzen 用户都能获得最佳使用体验。避免类似 Intel 13、14 代处理器大规模崩溃问题重演。

现在看来,AMD 芯片的印刷问题可能早已显露端倪。海外媒体 tomsHardware 的记者拿出了在 Zen 5 技术日拍摄的 Ryzen 9 9950X 的照片,与已经上市两年的 Ryzen 9 7950X 进行了对比,不难看出,「Ryzen 9 9950X」的每个单词之间的间距似乎比 AMD 奉行多年的标准都要更宽。

Ryzen 9 9950X 最初计划在 7 月 31 日发布,但现在 AMD 已经将 Ryzen 7 9700X 和 Ryzen 5 9600X 处理器的发布日期推迟到 8 月 8 日,更高端的 Ryzen 9 9950X 和 Ryzen 9 9900X 将推迟到 8 月 15 日。

至于 Ryzen 9 9950X 和 Ryzen 9 9900X 上的字有没有印对,目前还没有定论。然而可以肯定的是,一旦更高端的型号出了岔子,肯定要比 Ryzen 7 系列和 5 系列推迟的时间更久。

对于用户来说,如果芯片延迟发布唯一的原因只是因为字印错了,而不是质量问题,反倒令人安心。对于 AMD 而言,他们似乎让自己陷入了一个尴尬的境地,如果芯片的印刷错误被证明是唯一的问题,那么 AMD 为何选择回避,不直接向公众坦白,而是发表了一个含糊其辞的声明,这种做法反而激起了外界对其芯片品质和检验流程的疑虑。

参考内容:

https://www.tomshardware.com/pc-components/cpus/amd-ryzen-9000-launch-delay-due-to-typo-ryzen-7-9700x-ryzen-5-9600x-confirmed

https://www.anandtech.com/show/21485/the-amd-ryzen-ai-hx-370-review

https://www.youtube.com/watch?v=MCi8jgALPYA

#CFOR(Cross Fork Object Reference)

私有数据、删掉的内容可以永久访问,GitHub官方:故意设计的

最近,一个消息震惊开源社区:在 GitHub 上删掉的内容、私有存储库的数据都是可以永久访问的,而且这是官方故意设计的。

开源安全软件公司 Truffle Security 在一篇博客中详细描述了这个问题。

Truffle Security 引入了一个新术语:CFOR(Cross Fork Object Reference):当一个存储库 fork 可以访问另一个 fork 中的敏感数据(包括来自私有和已删除 fork 的数据)时,就会出现 CFOR 漏洞。

与不安全的直接对象引用类似,在 CFOR 中,用户提供提交(commit)哈希值就可以直接访问提交数据,否则这些数据是不可见的。

以下是 Truffle Security 博客原文内容。

访问已删除 fork 存储库的数据

想象如下工作流程:

- 在 GitHub 上 fork 一个公共存储库;

- 将代码提交到你的 fork 存储库中;

- 你删除你的 fork 存储库。

那么,你提交给 fork 的代码应该是不能访问了对吧,因为你把 fork 存储库删除了。然而它却永久可以访问,不受你控制。

如下视频所示,fork 一个存储库,向其中提交数据,再删除 fork 存储库,那么可以通过原始存储库访问「已删除」的提交数据。

这种情况普遍存在。Truffle Security 调查了一家大型 AI 公司 3 个经常被 fork 的公共存储库,并从已删除的 fork 存储库中轻松找到了 40 个有效的 API 密钥。

访问已删除存储库的数据

考虑如下工作流程:

- 你在 GitHub 上有一个公共存储库;

- 用户 fork 你的存储库;

- 你在他们 fork 后提交数据,并且他们从不将其 fork 存储库与你的更新同步;

- 你删除整个存储库。

那么,用户 fork 你的存储库后你提交的代码仍然可以访问。

GitHub 将存储库和 fork 存储库储存在存储库网络中,原始「上游」存储库充当根节点。当已 fork 的公共「上游」存储库被「删除」时,GitHub 会将根节点角色重新分配给下游 fork 存储库之一。但是,来自「上游」存储库的所有提交仍然存在,并且可以通过任何 fork 存储库访问。

2

这种情况不是个例,上周就发生了这样一件事情:

Truffle Security 向一家大型科技公司提交了一个 P1 漏洞,显示他们意外地提交了一名员工 GitHub 帐户的密钥,而该帐户对整个 GitHub 机构拥有重要访问权限。该公司立即删除了存储库,但由于该存储库已被 fork,因此仍然可以通过 fork 存储库访问包含敏感数据的提交,尽管 fork 存储库从未与原始「上游」存储库同步。

也就是说,只要存储库有至少一个 fork 存储库,那么提交到公共存储库的任何代码都可以永久访问。

访问私有存储库数据

考虑如下工作流程:

- 你创建一个最终将公开的私有存储库;

- 创建该存储库的私有内部版本(通过 fork),并为不打算公开的特征提交额外的代码;

- 你将你的「上游」存储库公开,并将你的 fork 存储库保持私有。

那么,私有特征和相关代码则可供公众查看。从你创建工具的内部 fork 存储库到开源该工具之间提交的任何代码,这些提交都可以通过公共存储库访问。

在你将「上游」存储库公开后,对你的私有 fork 存储库所做的任何提交都是不可见的。这是因为更改私有「上游」存储库的可见性会导致两个存储库网络:一个用于私有版本,一个用于公开版本。

不幸的是,该工作流程是用户和机构开发开源软件时最常用的方法之一。因此,机密数据可能会无意中暴露在 GitHub 公共存储库上。

如何访问数据?

GitHub 存储库网络中的破坏性操作(如上述 3 个场景)会从标准 GitHub UI 和正常 git 操作中删除提交数据的引用。但是,这些数据仍然存在并且可以访问(commit hash)。这是 CFOR 和 IDOR 漏洞之间的联系。

commit hash 可以通过 GitHub 的 UI 进行暴力破解,特别是因为 git 协议允许在引用提交时使用短 SHA-1 值。短 SHA-1 值是避免与另一个 commit hash 发生冲突所需的最小字符数,绝对最小值为 4。所有 4 个字符 SHA-1 值的密钥空间为 65536 (16^4)。暴力破解所有可能的值可以相对容易地实现。

有趣的是,GitHub 公开了一个公共事件 API 端点。你还可以在由第三方管理的事件存档中查询 commit hash,并将过去十年的所有 GitHub 事件保存在 GitHub 之外,即使在存储库被删除之后也是如此。

GitHub 的规定

Truffle Security 通过 GitHub 的 VDP 计划将其发现提交给了 GitHub 官方。GitHub 回应道:「这是故意设计的」,并附上了说明文档。

说明文档:https://docs.github.com/en/pull-requests/collaborating-with-pull-requests/working-with-forks/what-happens-to-forks-when-a-repository-is-deleted-or-changes-visibility

Truffle Security 赞赏 GitHub 对其架构保持透明,但 Truffle Security 认为:普通用户将私有和公共存储库的分离视为安全边界,并且认为公共用户无法访问私有存储库中的任何数据。不幸的是,如上所述,情况并不总是如此。

Truffle Security 得出的结论是:只要一个 fork 存储库存在,对该存储库网络的任何提交(即「上游」存储库或「下游」fork 存储库上的提交)都将永久存在。

Truffle Security 还提出一种观点:安全修复公共 GitHub 存储库上泄露密钥的唯一方法是通过密钥轮换。

GitHub 的存储库架构存在这些设计缺陷。不幸的是,绝大多数 GitHub 用户永远不会理解存储库网络的实际工作原理,并且会因此而降低安全性。

原文链接:https://trufflesecurity.com/blog/anyone-can-access-deleted-and-private-repo-data-github

#Stretching Each Dollar

1890美元,就能从头训练一个还不错的12亿参数扩散模型, 只用1890美元、3700 万张图像,就能训练一个还不错的扩散模型。

现阶段,视觉生成模型擅长创建逼真的视觉内容,然而从头开始训练这些模型的成本和工作量仍然很高。比如 Stable Diffusion 2.1 花费了 200000 个 A100 GPU 小时。即使研究者使用最先进的方法,也需要在 8×H100 GPU 上训练一个多月的时间。

此外,训练大模型也对数据集提出了挑战,这些数据基本以亿为单位,同样给训练模型带来挑战。

高昂的训练成本和对数据集的要求为大规模扩散模型的开发造成了难以逾越的障碍。

现在,来自 Sony AI 等机构的研究者仅仅花了 1890 美元,就训练了一个不错的扩散模型, 具有 11.6 亿参数的稀疏 transformer。

- 论文地址:https://arxiv.org/pdf/2407.15811

- 论文标题:Stretching Each Dollar: Diffusion Training from Scratch on a Micro-Budget

- 项目(即将发布):https://github.com/SonyResearch/micro_diffusion

具体而言,在这项工作中,作者通过开发一种低成本端到端的 pipeline 用于文本到图像扩散模型,使得训练成本比 SOTA 模型降低了一个数量级还多,同时还不需要访问数十亿张训练图像或专有数据集。

作者考虑了基于视觉 transformer 的潜在扩散模型进行文本到图像生成,主要原因是这种方式设计简单,并且应用广泛。为了降低计算成本,作者利用了 transformer 计算开销与输入序列大小(即每张图像的 patch 数量)的强依赖关系。

本文的主要目标是在训练过程中减少 transformer 处理每张图像的有效 patch 数。通过在 transformer 的输入层随机掩蔽(mask)掉部分 token,可以轻松实现这一目标。

然而,现有的掩蔽方法无法在不大幅降低性能的情况下将掩蔽率扩展到 50% 以上,特别是在高掩蔽率下,很大一部分输入 patch 完全不会被扩散 transformer 观察到。

为了减轻掩蔽造成的性能大幅下降,作者提出了一种延迟掩蔽(deferred masking)策略,其中所有 patch 都由轻量级 patch 混合器(patch-mixer)进行预处理,然后再传输到扩散 transformer。Patch 混合器包含扩散 transformer 中参数数量的一小部分。

与 naive 掩蔽方法相比,在 patch mixing 处理之后进行掩蔽允许未掩蔽的 patch 保留有关整个图像的语义信息,并能够在非常高的掩蔽率下可靠地训练扩散 transformer,同时与现有的最先进掩蔽相比不会产生额外的计算成本。

作者还证明了在相同的计算预算下,延迟掩蔽策略比缩小模型规模(即减小模型大小)实现了更好的性能。最后,作者结合 Transformer 架构的最新进展,例如逐层缩放、使用 MoE 的稀疏 Transformer,以提高大规模训练的性能。

作者提出的低成本训练 pipeline 减少了实验开销。除了使用真实图像,作者还考虑在训练数据集中组合其他合成图像。组合数据集仅包含 3700 万张图像,比大多数现有的大型模型所需的数据量少得多。

在这个组合数据集上,作者以 1890 美元的成本训练了一个 11.6 亿参数的稀疏 transformer,并在 COCO 数据集上的零样本生成中实现了 12.7 FID。

值得注意的是,本文训练的模型实现了具有竞争力的 FID 和高质量生成,同时成本仅为 stable diffusion 模型的 1/118 ,是目前最先进的方法(成本为 28,400 美元)的 1/15。

方法介绍

为了大幅降低计算成本,patch 掩蔽要求在输入主干 transformer 之前丢弃大部分输入 patch,从而使 transformer 无法获得被掩蔽 patch 的信息。高掩蔽率(例如 75% 的掩蔽率)会显著降低 transformer 的整体性能。即使使用 MaskDiT,也只能观察到它比 naive 掩蔽有微弱的改善,因为这种方法也会在输入层本身丢弃大部分图像 patch。

延迟掩蔽,保留所有 patch 的语义信息

由于高掩蔽率会去除图像中大部分有价值的学习信号,作者不禁要问,是否有必要在输入层进行掩蔽?只要计算成本不变,这就只是一种设计选择,而不是根本限制。事实上,作者发现了一种明显更好的掩蔽策略,其成本与现有的 MaskDiT 方法几乎相同。由于 patch 来自扩散 Transformer 中的非重叠图像区域,每个 patch 嵌入都不会嵌入图像中其他 patch 的任何信息。因此,作者的目标是在掩蔽之前对 patch 嵌入进行预处理,使未被掩蔽的 patch 能够嵌入整个图像的信息。他们将预处理模块称为 patch-mixer。

使用 patch-mixer 训练扩散 transformer

作者认为,patch-mixer 是任何一种能够融合单个 patch 嵌入的神经架构。在 transformer 模型中,这一目标自然可以通过注意力层和前馈层的组合来实现。因此,作者使用一个仅由几个层组成的轻量级 transformer 作为 patch-mixer。输入序列 token 经 patch-mixer 处理后,他们将对其进行掩蔽(图 2e)。

图 2:压缩 patch 序列以降低计算成本。由于扩散 transformer 的训练成本与序列大小(即 patch 数量)成正比,因此最好能在不降低性能的情况下缩减序列大小。这可以通过以下方法实现:b) 使用更大的 patch;c) 随机简单(naive)掩蔽一部分 patch;或者 d) 使用 MaskDiT,该方法结合了 naive 掩蔽和额外的自动编码目标。作者发现这三种方法都会导致图像生成性能显著下降,尤其是在高掩蔽率的情况下。为了缓解这一问题,他们提出了一种直接的延迟掩蔽策略,即在 patch-mixer 处理完 patch 后再对其进行掩蔽。除了使用 patch-mixer 之外,他们的方法在所有方面都类似于 naive 掩蔽。与 MaskDiT 相比,他们的方法无需优化任何替代目标,计算成本几乎相同。

假定掩码为二进制掩码 m,作者使用以下损失函数来训练模型:

其中,M_ϕ 是 patch-mixer 模型,F_θ 是主干 transformer。请注意,与 MaskDiT 相比,本文提出的方法还简化了整体设计,不需要额外的损失函数,也不需要在训练过程中在两个损失之间进行相应的超参数调优。在推理过程中,该方法不掩蔽任何 patch。

未掩蔽微调

由于极高的掩蔽率会大大降低扩散模型学习图像全局结构的能力,并在序列大小上引入训练 - 测试分布偏移,因此作者考虑在掩蔽预训练后进行少量的未掩蔽微调。微调还可以减轻由于使用 patch 掩蔽而产生的任何生成瑕疵。因此,在以前的工作中,恢复因掩蔽而急剧下降的性能至关重要,尤其是在采样中使用无分类器引导时。然而,作者认为这并不是完全必要的,因为即使在掩蔽预训练中,他们的方法也能达到与基线未掩蔽预训练相当的性能。作者只在大规模训练中使用这种方法,以减轻由于高度 patch 掩蔽而产生的任何未知 - 未知生成瑕疵。

利用 MoE 和 layer-wise scaling 改进主干 transformer 架构

作者还利用 transformer 架构设计方面的创新,在计算限制条件下提高了模型的性能。

他们使用混合专家层,因为它们在不显著增加训练成本的情况下增加了模型的参数和表现力。他们使用基于专家选择路由的简化 MoE 层,每个专家决定路由给它的 token,因为它不需要任何额外的辅助损失函数来平衡专家间的负载。他们还考虑了 layer-wise scaling,该方法最近被证明在大型语言模型中优于典型 transformer。该方法线性增加 transformer 块的宽度,即注意力层和前馈层的隐藏层维度。因此,网络中较深的层比较早的层被分配了更多的参数。作者认为,由于视觉模型中的较深层往往能学习到更复杂的特征,因此在较深层使用更高的参数会带来更好的性能。作者在图 3 中描述了他们提出的扩散 Transformer 的整体架构。

图 3:本文提出的扩散 transformer 的整体架构。作者在骨干 transformer 模型中加入了一个轻量级的 patch-mixer,它可以在输入图像中的所有 patch 被掩蔽之前对其进行处理。根据当前的研究成果,作者使用注意力层处理 caption 嵌入,然后再将其用于调节。他们使用正弦嵌入来表示时间步长。他们的模型只对未掩蔽的 patch 进行去噪处理,因此只对这些 patch 计算扩散损失(论文中的公式 3)。他们对主干 transformer 进行了修改,在单个层上使用了 layer-wise scaling,并在交替 transformer 块中使用了混合专家层。

实验

实验采用扩散 Transformer(DiT)两个变体 DiT-Tiny/2 和 DiT-Xl/2。

如图 4 所示,延迟掩蔽方法在多个指标中都实现了更好的性能。此外,随着掩蔽率的增加,性能差距会扩大。例如,在 75% 的掩蔽率下,naive 掩蔽会将 FID 得分降低到 16.5(越低越好),而本文方法可以达到 5.03,更接近没有掩蔽的 FID 得分 3.79。

表 1 表明 layer-wise scaling 方法在扩散 transformer 的掩蔽训练中具有更好的拟合效果。

比较不同的掩蔽策略。作者首先将本文方法与使用较大 patch 的策略进行比较。将 patch 大小从 2 增加到 4,相当于 75% 的 patch 掩蔽。与延迟掩蔽相比,其他方法表现不佳,分别仅达到 9.38、6.31 和 26.70 FID、Clip-FID 和 Clip-score。相比之下,延迟掩蔽分别达到 7.09、4.10 和 28.24 FID、Clip-FID 和 Clip-score。

下图为延迟掩蔽 vs. 模型缩小以减少训练成本的比较。在掩蔽率达到 75% 之前,作者发现延迟掩蔽在至少三个指标中的两个方面优于网络缩小。但是,在极高的掩蔽率下,延迟掩蔽往往会实现较低的性能。这可能是因为在这些比率下掩蔽的信息损失太高导致的。

表 5 提供了有关模型训练超参数的详细信息。训练过程分两个阶段。

计算成本。表 2 提供了每个训练阶段的计算成本明细,包括训练 FLOP 和经济成本。第 1 阶段和第 2 阶段训练分别消耗了总计算成本的 56% 和 44%。模型在 8×H100 GPU 集群上的总时钟训练时间为 2.6 天,相当于在 8×A100 GPU 集群上为 6.6 天。

了解更多结果,请参考原论文。

#AI生图玩法猛猛上新

日均tokens使用量超5000亿,AI生图玩法猛猛上新:豆包大模型为什么越来越「香」了?

2024 年的 AI 图像生成技术,又提升到了一个新高度。

技术的飞速迭代,让这一领域的商业化落地进入加速阶段。前有 Midjourney v6 史诗级更新,后有开源巨头 Stable Diffusion 3 独领风骚,而 DALL・E 3 背靠 ChatGPT 这棵「大树」,也收获了众多用户的关注。

当然了,在这条赛道上,来自国内的选手毫不逊色。

近日,国产大模型「顶流」—— 字节跳动豆包大模型,迎来一场集中放送:

在 2024 火山引擎 AI 创新巡展成都站活动上,豆包大模型团队公布了豆包大模型的最新进展,以及文生图模型、语音模型等垂直模型的新升级。

与此同时,豆包大模型家族的最新成员 ——「豆包・图生图模型」正式面世,一口气上新了 50 多项玩法。

作为国产大模型中的实力之作,豆包大模型在今年 5 月通过火山引擎正式对外提供服务。尽管入场时间不是最早,但今天的豆包大模型已经是国内使用量最大、应用场景最丰富的大模型之一。

这场活动中,火山引擎还透露了一个数字:截至 2024 年 7 月,豆包大模型的日均 tokens 使用量已经超过 5000 亿。

与此同时,豆包大模型的技术实力在短时间内也经历了多次迭代。在多个公开评测集以及专业的第三方评测中,豆包通用模型 pro 均表现出众,是得分最高的国产大模型。

至于豆包大模型的「功力」究竟练到了哪一层?我们不妨体验一把再下结论。

国产 AI 猛猛上新

豆包大模型为什么能俘获用户的心?

我们就从刚刚更新的图像生成方面来考验一下豆包大模型。对 AIGC 应用接触比较多的用户可能都有一个感受:AI 图像生成类产品越来越卷,彼此之间也越来越难拉开差距。

这种直观感受的变化,几乎能完全对应上底层技术的演进节点。与一些早期 GAN 模型的生成水准相比,如今的图像生成质量已经让大部分人觉得「真假难辨」。在这个过程中,学界和业界对图像生成质量的评估维度也发生了巨大变化:像 FID Score 这样的指标已经不足以全面反映模型能力,人类评估成为了评估图像生成质量的黄金标准。尽管经济和时间成本更高,但这种方式可以提供更加细微且可解释的感知反馈。

以「文生图」方向为例,现阶段的目标可以总结为对综合维度的全面提升,具体可拆分为图像美感、图文一致性、内容创造、复杂度适应性四个维度。在这几方面,豆包・文生图都达到了业界较高水准。

在用户感受最强烈的「图文匹配」维度上,豆包・文生图模型不断进化,比如很好地理解多数量主体、主客体关系、人物构造和空间构造等信息:

Prompt:古代日本鬼机甲、中国朋克、太空歌剧、科幻小说、古代未来主义、神秘、明亮、不对称密集构图、32k 超高清、电影光、气氛光、电影、柔和的调色板、超现实、自由度、自然体积光。

而在「画面效果美感」层面,豆包・文生图模型非常善于从光影明暗、氛围色彩和人物美感方面进行画面质感提升:

Prompt:OC 渲染,3D 设计,长发小女孩,人脸朝着镜头,中心构图,帽子上长满鲜花,轮廓清晰,面部细节放大,帽子细节放大,画质高清,超清画质,深景深,背景是花海

此外,作为国产 AI 精品之作,面对中国人物、物品、朝代、美食、艺术风格等元素,豆包・文生图模型也展现出了更加深刻的理解力。

Prompt:超写实画风,唐代,长安,元宵节夜市,唐代侍女,灯火辉煌,细节完美,特写,热闹非凡,超高清,4K

Prompt:国风水墨绘画,点彩、肌理磨砂、陈家泠、大面留白的构图,高清16k故宫远景,雪景、流畅建筑结构,层次,白色主色,淡雅

基于双语大模型文本编码器,豆包・文生图模型对英文 Pormpt 的理解同样精准:

Prompt:butterfly candle, in the style of y2k aesthetic, pop-culture-infused, jewelry by painters and sculptors, text and emoji installations, money themed, playful animation, humble charm

Prompt:World of Warcraft, outdoor scene, green grassland with a river flowing through it, rocky cliffside with a cave entrance, a small wooden bridge over the waterway, lush trees and wildflowers on both sides of the stream, white clouds in a blue sky, fantasy landscape concept art style, game illustration design, concept design for world building, concept art in the style of game illustration design, 3D

不久之后,豆包・文生图模型还将升级到 2.0 版本。豆包视觉团队表示,新版本将比当前模型的生成效果有 40% 的提升,对比当前版本,图文一致性和美感会有大幅提升。

与文生图略有不同,在图像美感和结构等因素之外,图生图更算是一种应用模型,质量评估更加关注「一致性」和「相似度」两个维度。豆包・图生图模型的能力涵盖「AI 写真」、「图像风格化」、「扩图 / 局部重绘」三个主要方向,共提供了 50 余种风格玩法。

「AI 写真」算是以图生图方向中使用频率非常高的一种玩法,豆包・图生图模型的一大亮点是高度还原人物特征,能够精准捕捉轮廓、表情、姿态等多维特征,轻松生成定制化写真:

豆包・图生图模型还能具备优秀的图片扩展、局部重绘和涂抹能力,在逻辑合理的前提下,还能充满想象力。

比如在下方的任务中,用户想要实现自然的局部消除,豆包・图生图模型生成结果也做到了平滑过渡:

对于只想局部进行重绘的需求,豆包・图生图模型能够精准修改图像局部内容,无缝融合原有画面。比如将粉色外套改为蓝色牛仔外套:

面对下方的人物照背景扩图任务,豆包・图生图模型给出的结果,实现了良好的景观结构及光线保持:

豆包大模型,如何跻身图像生成赛道上游?

感受完这一波 Demo,我们好奇:是从什么时候开始,豆包大模型在图像生成方面有了这么深厚的实力?

两年前,Stable Diffusion 的横空出世,宣告了 AIGC 时代的正式开启。随后,AI 社区形成了巨大的迭代效应,基于各个版本 Stable Diffusion 开源模型的 AI 图像生成工具被迅速创造出来,不断刷新生成质量和速度的上限。

不到半年后,DiT 架构的提出,验证了 Scaling Law 在图像生成领域同样成立。越来越多的研究选择用 Transformer 替代传统的 U-Net,让扩散模型继承了其他领域的最佳实践和训练方法,增强了图像生成模型的可扩展性、鲁棒性和效率,还提高了对文字提示的理解能力和图像生成质量,有效增加了定制化、生成内容可控性方面的优势。

早在豆包大模型诞生前的几年,字节跳动就开始关注图像生成相关技术,近两年更是持续增加这方面的研发投入,保持着创新成果的高频产出。这也是为什么豆包大模型一经面世,就可以惊艳所有人。

Scaling Law 被验证带来的另外一个启示是,算力基础提升、训练数据增加、数据质量改善成为了图像生成模型能力提升的关键因素。在这些方面,字节跳动自研的豆包大模型在图像生成能力进化上具备天然优势。

但 Stable Diffusion 模型的训练和推理仍然是一个复杂且耗时的过程,比如,扩散模型在推理过程中天然存在的多步数迭代去噪特性会导致较高的计算成本。如何在提升生成质量的同时加快速度,成为了图像生成领域的关键问题。

豆包视觉团队提出了多项创新成果,从不同的维度尝试解决这个难题,并将这些成果开放给了 AI 社区。

一项代表性的成果是 Hyber-SD,这是一种新颖的扩散模型蒸馏框架,在压缩去噪步数的同时可保持接近无损的性能,在 SDXL 和 SD1.5 两种架构上都能在 1 到 8 步内生成中实现 SOTA 级别的图像生成。(https://huggingface.co/ByteDance/Hyper-SD)

另外一项研究 SDXL- Lightning则通过一种名为「渐进式对抗蒸馏」(Progressive Adversarial Distillation)的创新技术,实现了生成质量和生成速度的双重提升:仅需短短 2 步或 4 步,模型就能生成极高质量和分辨率的图像,将计算和时间成本降低了十倍,而且能在实现更高分辨率和更佳细节的同时保持良好的多样性和图文匹配度。(https://huggingface.co/ByteDance/SDXL-Lightning)

同时,豆包视觉团队还提出了一个利用反馈学习全面增强扩散模型的统一框架 UniFL。通过整合感知、解耦和对抗性反馈学习,这个框架不仅在生成质量和推理加速方面表现优秀,还在 LoRA、ControlNet、AnimateDiff 等各类下游任务中展现出了很好的泛化能力。(https://arxiv.org/pdf/2404.05595)

众所周知,Stable Diffusion 的核心功能是从文本生成图像,而 ControlNet、Adapter 等技术的融合,能够在保留部分图像信息的同时添加一些额外控制条件,引导生成与给定参考图像「相似」的结果。这些技术的融合演变出了我们今天见到的各项「图生图」功能,并进一步消除了 AI 图像生成技术的商用门槛。

在这方面,豆包视觉团队同样有深厚技术积累,仅今年就在国际计算机视觉顶会 CVPR 中发表了十多篇论文,提出了数十项相关专利。

针对图像 Inpaint/Outpaint 问题,豆包视觉团队提出了 ByteEdit。关键创新包括三点:首先,增大训练数据量级,兼容自然图像输入、mask 输入、无 prompt 输入,让模型「看到」更多泛化场景;其次,引入一致性奖励模型,重点提升生成结果一致性,让希望填充的区域和非填充区域更加的和谐;然后,引入渐进式的分阶段对抗训练策略,在不损失模型性能条件下实现速度的提升。(https://byte-edit.github.io)

针对 ID 保持,豆包视觉团队提出了 PuLID,通过引入一个新的训练分支,在训练中加入了对比对齐损失和更精确的 ID 损失,让 ID 适配器学习如何在注入的 ID 信息的同时,减少对原模型行为的破坏,从而在保证较高 ID 相似度的同时,兼顾编辑能力、风格化能力以及画面质量等方面的效果。(https://www.hub.com/ToTheBeginning/PuLID)

针对 IP 保持,豆包视觉团队提出了一种「参考图 IP - 文本」解耦控制的通用场景 IP 定制化生成方法 RealCustom,对于任意开放域物体或人物 IP 均可实现无需微调的实时定制化生成。(https://corleone-huang.github.io/realcustom/)

「更强模型、更低价格、更易落地」

短短两年内,AI 在图像生成上的持续进步,打破了长期存在的专业门槛,让任何人都可以创造出高质量的视觉作品,带来了一场前所未有的革命。豆包大模型的图像生成能力,已经为字节跳动旗下多个应用提供技术支持,包括抖音、剪映、醒图、即梦、豆包、星绘。对于大众来说,AIGC 已经实实在在地改变了生活。

但从企业用户的角度来说,这些最前沿的技术仍然存在一些应用壁垒,涉及数据、人才、算力等多方面因素。对于各行各业的用户来说,即使有了强大的开源模型可供选择,也需要解决计算资源、专业知识、模型微调等方面的挑战。

成本的全方位降低,才是推动大模型真正实现价值创造的关键因素。

自发布以来,豆包大模型正在通过火山引擎源源不断地向千行百业输出技术能力,推动大模型技术实现更广泛深入的行业落地。

目前,包括豆包・文生图模型和豆包・图生图模型在内,豆包大模型家族的成员数量已经达到了 10 个。这些针对应用场景细分的模型都会上线火山方舟,开放给火山引擎的众多企业客户合作共创。

飞速增长的使用量,也在帮助豆包大模型持续打磨自身能力。自 2024 年 5 月 15 日豆包大模型发布至今,短短两个月内,平均每家企业客户的日均 tokens 使用量已经增长了 22 倍。

豆包大模型家族「集体照」。

同时,火山引擎提供了更丰富的核心插件、更强大的系统性能以及更优质的平台体验,企业可根据自身业务场景需求灵活选择、快速落地。比如,依靠豆包・图生图模型,客户利用几张图片即可训练专属的数字分身。

在很多情况下,价格仍然是客户的首要考虑因素。火山引擎正是率先将最强模型版本降价的行业先行者,以更强模型、更低价格满足企业复杂业务场景需求,真正推动大模型落地。

凭借充沛 GPU 算力资源池,并通过潮汐、混部等方式,实现资源的高利用率和极致降低成本,即使是在大模型价格战越来越激烈的未来,火山引擎所提供的大模型服务仍然保持着绝对吸引力。

中国公司正在开启大模型竞争的下一章

轰轰烈烈的百模大战之后,海内外的大模型快速涌现。尽管有 OpenAI 等一系列强大的竞争对手,但豆包大模型还是杀出了自己的一条路。

过去一段时间,人们喜欢谈论国产大模型技术的追赶。从「追赶」到「媲美」,很多中国团队只用了一年、半年时间,这其中也包括豆包大模型团队。

短时间内跻身图像生成这条赛道的上游,与豆包大模型团队在研发和人才方面的投入密不可分。近几年,越来越多顶尖大模型人才的加入,纯粹极致的技术研究氛围,大规模的研发资源投入,都是成就豆包这一国产大模型代表作的重要因素。

特别是在应用场景优势的加持下,当大模型被「用起来」的这天,人们看到了中国大模型走进千行百业时的充足「后劲」。

可以期待的是,大模型这条赛道的竞争正在开启新篇章,而在新的章节里,国产大模型将有机会书写更加浓墨重彩的一笔。

#X Square

具身智能GPT-2时刻到了!这家国内公司已做出全球最大规模的端到端统一具身大模型——专访自变量机器人团队

近日,关于 Open AI 被投企业 Physical Intelligence (PI) 的一系列报道,让人们关注到具身智能大模型引发的机器人时代变革。

目光转回国内,我们同样在中国公司中发现了这场变革浪潮的先行者。据了解,国内初创公司自变量机器人(X Square),是国内唯一一家从第一天就选择了端到端统一大模型技术路线的公司,与 PI 的技术路线不谋而合。这家公司正在训练的 Great Wall 操作大模型系列的 WALL-A 甚至从参数规模上已经超过了 PI。

今年 4 月,曾对自变量机器人公布的 Demo 进行报道,其中基于他们自研的端到端统一具身大模型,双臂机器人可利用低成本硬件即实现对不规则物体的精细操作(如抓握、拾取、切割等),以及折叠衣服、冲泡饮料等复杂任务,展现出相当程度的泛化性能。

当前,自变量机器人的模型效果已达到惊人水准,体现在包括处理长序列复杂任务,以及泛化性、通用性等方面。

,时长00:14

拉拉链对机器人来说极为困难,机器人除了仅依靠位置控制来完成微小拉链头的插入,滑块与链齿的精准对齐和适度力度的拉动,还需要实时应对布料变形带来的干扰,并能够准确判断拉链的咬合状态以及处理布料卡住等异常情况。

,时长00:14

,时长00:15

织物操作是操作任务中最困难和复杂的任务之一。织物是柔性无序物体,晾晒/整理/折叠衣物任务面临识别并理解柔性物体的拓扑结构的挑战(比如衣物展开要从完全无序状态中识别领口/袖子等结构;衣架插入要理解衣物的前后层次;衣物折叠要理解折叠的结构),对模型的感知和理解能力要求很高。其次,在叠衣服的过程中,织物的运动和摩擦有大量随机性,形态极难预测,需要模型进行实时感知和修正,要求极强的鲁棒性。

这种处理复杂任务以及「泛化」的能力,正是自变量机器人团队对机器人「Scaling Law」的探索成果,他们希望用单一的大模型来驱动端到端的机器人 manipulation。

目前,这家成立不到一年的中国初创企业,已经做出了世界上最大规模的端到端统一具身大模型「WALL-A」,并在多个维度上超过了所有已知模型。

自变量机器人认为,目前 Great Wall 系列的 WALL-A 类似于「GPT-2」,伴随着模型的不断迭代,机器人领域的「ChatGPT」时刻可能会在不久后来到。

令大家好奇的是,这家年轻的初创公司,将会如何实现这一宏伟目标?

近日,自变量机器人接受了采访,介绍了他们正在进行的有关于技术边界的探索,以及这场机器人浪潮下的一些思考。

世界上最大规模的端到端统一具身大模型

X Square 正在训练的 WAll-A 是一个怎样的模型?

WALL-A 是世界上最大规模的端到端统一具身大模型。在多个维度上,我们的模型都超过了目前已知的所有模型的能力。

比如,从任务复杂度层面来说,我们能够做拉拉链、扣扣子、整理衣物等精细、随机且涉及复杂拓扑结构的任务;从通用性、泛化性层面来说,我们可以做到用极少的样本,完成各种物理环境变量、动作模式的泛化和迁移。

「通用性」和「泛化性」是定义这一代具身智能技术最核心的要素。只有达到足够的通用性、泛化性和可迁移性,才能实现在自由环境中,不受预设环境和预设物体限制的自由操作,才是真正区别于「自动化」及以往专用机器人的新一代机器人。

为什么将其定义为机器人领域的「大统一」模型?

第一个维度,是我们实现了端到端的纵向统一。从最原始的视频、传感器信号,到最后机器人的速度、位姿、力矩,完全用一个模型解决,中间没有任何切分的步骤,排除了分层所带来的噪声。

第二个维度,是我们实现了任务的横向统一,所有的任务放在同一个模型中训练,推理的时候也用同一模型进行操作。

对于一切操作任务,一个单一的模型即可解决所有问题,因此称之为「大统一」模型。

据我们所知,不只是 PI,海外的明星创业公司目前都在走这条路线,但国内只有我们在走。

这种「大统一」模型与大语言模型、多模态大模型以及之前的机器人模型的关系是?

统一具身模型的技术方向,既完全不同于传统机器人学习的小模型技术,也完全不同于以往语言、多模态大模型的技术。

首先,大模型的技术栈和小模型完全不同,两者之间没有什么可迁移性。和大模型背景的同学们讨论的更多是计算图优化、混合精度训练如何收敛、并行调度之类的问题;和做机器人或者小模型的同学们讨论的更多是模型的某个设计能够起到什么样的作用或者某个 Bound 是否太松。即使都聊起模型,大模型和小模型的同学们视角也完全不同:大模型最重视的是否方便 Scale Up,小模型更重视「可分析」和「结构设计」。

其次,这件事在数据工程方面有着更高的要求。目前有几十个模型在支撑我们的数据系统。同时,公司自研了一系列数据采集设备。

此外,在所有 AI 领域的细分赛道中,机器人的门槛几乎是最高的,因为和语言或者视觉有明显区别的一点是,机器人领域中的 Domain Knowledge 实在太多,怎么站在大模型的语境下看这些 Domain Knowledge 很重要。另外机器人模型涉及的模态空前的多和复杂,对模型要求的重点也和以往的语言或多模态模型很不一样,如果不是同时有两方面的背景,可能很难把这件事完成好。

所以你们的技术团队是按照怎样的思路组建的?目前是怎样一个构成?

创始人兼 CEO 王潜本硕毕业于清华大学,是全球最早在神经网络中引入注意力机制的学者之一。博士期间,王潜在美国顶级机器人实验室参与了多项 Robotics Learning 的研究,方向覆盖了机器人多个前沿领域。

联合创始人兼 CTO 王昊博士毕业于北京大学,在粤港澳大湾区数字经济研究院(IDEA 研究院)期间担任封神榜大模型团队负责人,发布了国内首个多模态大模型「太乙」,首批百亿级大语言模型「燃灯 / 二郎神」及千亿级大语言模型「姜子牙」,模型累计下载量数百万。

王潜:面对机器人大模型这波潮流,很多团队可能因为「沉没成本」和「路径依赖」而止步不前。我自己是全球最早引入 Attention 机制的学者之一,在人工智能浪潮兴起的时候,我意识到纯 AI 在落地方面的天花板,所以我出国去搞机器人;在机器人方面,我研究过当时最前沿的 topic,因而非常了解许多技术路径的瓶颈和天花板,把该经历和纠结的都经历了;从 20 年左右自己就看得很清楚通用机器人这事做成只有统一大模型这一条路;所以我们从第一天开始团队的组建和技术的探索就是完全为这个方向设置的,包括我们的技术框架和方向从第一天开始就没有改过。

王昊:我觉得王潜在这里的作用是决定性的,我还真没见过这样既懂机器人又真懂大模型的人。我自己切身的感受是机器人这个领域门槛实在太高了,而懂机器人的人里又确实几乎没人有过 scaling up 的经验,即使像原来 Google 的那批人离开了大平台的基础设施支持,能否做到以前的事情也是一个很大的问号。

原生的「Robotics Learning + 大模型」的创业组合,让 X Square 从第一天起就具备原始创新、对技术路径本质思考的基因。

端到端和统一模型是唯一的路径吗?

王潜:首先解释下「端到端」。从 2016 年开始,我已经认定,端到端是解决 manipulation 问题唯一可行的路径,本质上是因为 manipulation 和所有其他 AI / 机器人任务都有本质的区别,即涉及到的物理过程的复杂性远远超过其他任务。这个特点决定了任何分层分步的方法都很难彻底解决这一问题,因为模型不是完美的,每分出一个步骤,都一定会引入不准确的中间结果,即不可控的噪声。

拿最常见的分层方法中的 3D 重建来说,经常出现很多毛刺空洞之类缺陷,有时缺陷很小,人肉眼看的时候都不太能注意得到,但在物理接触中,哪怕一点点的毛刺都会导致结果完全不同。这类问题在每个步骤中都会叠加,最后得到的东西完全不可控。另外,每一个步骤都会丢弃掉大量的信息,而往往在最后控制的时候这些信息反而是重要的。

这也是我们团队与很多 CV / 自动驾驶背景团队最大的不同。很多人会觉得 manipulation 的核心在于 Spatial Intelligence(空间智能),只要能理解三维空间关系,这个问题自然迎刃而解,但据我们所知,做到这里只是问题的一半而已。

但在去年的时候,甚至直到今天,很多人并不真正相信端到端,或者说不认为统一是长期的趋势。去年只有我们在说端到端,大家普遍是不信的,但现在不说端到端都不好意思出门了(笑)。

2017 年,一个非常有名的机器人教授当面跟我说:「你搞的这种端到端的路线永远只能是 Toy Model,永远不可能走通。」我到今天还记得很清楚。一直到今年初,端到端在国内都仍然是非主流的判断,我们去年下半年说要做端到端,大家还是以不信为主,说实话我们得谢谢马斯克,特斯拉 FSDv12 给了大家很大的冲击。到了今年年中,端到端就已经「泛滥」了,大家都争相恐后挤到这条赛道上。

至于统一模型,端到端的共识形成尚且如此困难,统一模型的理解就更难了,因为它更加反直觉。直到今天,国内仍然只有我们实际上在走这条路。

之所以说「Foundation Model」是反直觉的道路,因为人们基于自身的经验,本能的会觉得把数据集中在一个领域做专家模型的效果会更好,但今天我们看到,「通才模型」才是真正能够打破天花板,在相同投入下达到更高能力的正确路径。

这条路线其实在其他领域已经有比较好的结果。例如,ChatGPT 是端到端的统一模型,也是所有任务统一的模型。又比如刚才提到的特斯拉 FSD,虽然只做一个领域任务,但是也是端到端完全统一和所有任务的完全统一。

王昊:还有关键的一点,机器人做学习最困难的点,是数据;要彻底解决数据问题,只有通过把所有任务的数据放到一个统一模型里面,靠学习所有任务中一致的 Common Structure,比如物理规律、物体特征,这也需要 Foundation Model 来解决。

机器人的「GPT-2 时刻」与 Scaling Law

数据质量 >> 数据多样性 >> 数据量

业界近来常说「机器人领域的 Scaling Law」,怎么理解?

王潜:很多人说到 Scaling Law,想到的一个词叫「大力出奇迹」,我觉得这是对 Scaling Law 庸俗和表面化的理解。关于这点,王昊应该有更深的感触。

王昊:因为我算是国内当时最早做大模型方向的一批人,包括在国内最早发布了百亿模型,但当时靠规模或者大力并没有明显地「出奇迹」。ChatGPT 出来之后,在最早期的时候大家都发现单纯做大数据规模根本复现不出来,直到有人开始从 ChatGPT 上直接拉数据做微调,才有了第一批做出来的大模型。

为什么会有这种情况出现,我觉得核心还是数据的质量。我们自己训练的感受是:数据质量对模型影响极大,好的数据可能几千条甚至几百条就有非常明显的效果,差的数据哪怕几千万上亿条,反而会让模型越训练越差,这都是我们在训练语言大模型和多模态大模型实践过程中切实看到过的,这个可能确实和一般人心中的「大力出奇迹」不一样。

王潜:确实,数据质量在 Scaling Law 里才是最核心的要素,其次是数据的多样性,排在最后的才是数据量。

当然也不是说数据量完全就不重要了,有些探讨 Scaling Law 的工作在每一个模型上只有几十条到几百条数据的结果,我们觉得意义似乎比较有限。真正给出机器人 Scaling Law 决定性证据的是 RT-X,因为它确实是在一个模型上放了几十万条数据。

大模型 + 机器人,路径走通了

基于哪些背景,你们选择在 2023 年底成立这家公司?

王潜:通用机器人发展的主要瓶颈在于智能而非硬件。以往,学术界和工业界有过非常多次向通用机器人的冲击,每次大家都抱有很大的希望,但后来都发现这个问题的困难程度远超过预期。在 AI 总体发展的过程中,我们逐渐发现莫拉维克悖论非常坚硬,机器人操作就是所有 AI 任务中最困难的一个,在 AI 本身有大的突破之前解决不太现实。

ChatGPT 从根本上改变了 AI 整个领域,对机器人来说有两个点:一是很多以前觉得极其困难的问题获得了突飞猛进的发展,例如 Planning、Reasoning、Language Interaction;二是从方法论上指明了解决机器人通用操作这一最核心问题的路线,一下子就看得很清楚了,对大家的解释成本一下子变得很低。

我自己从 2016 年开始做端到端的机器人模型,19 年到 21 年基本上看清楚了统一大模型这个大方向,但那个时候不管是资本还是学术界的主流,让大家理解和接受这种方法论都是有极大的障碍的。有了 ChatGPT 之后,「既然对 NLP 这么复杂的任务这套路线能够 work,对机器人这个复杂度类似的任务应该也能 work」,这种逻辑被大家所理解了。

所以我的决心是 22 年下的,但 23 年上半年我还在考虑是否在美国做这个大模型与机器人深度耦合的创业更容易成,到年中逐渐明确了这件事情在中国做有本质的优势。正好这与王昊在具身智能上的想法相契合,所以我们就一起组建了这个团队。

王昊:过去我一直做大模型,在长期的实践过程中,大家逐渐触碰到了一个本质困难:大语言模型对真实世界的幻觉始终难以消除。大语言模型就像一个生活在纯文本世界里的 「大脑」,它可以通过海量的文字习得知识,但始终缺乏最基础的物理认知和现实世界的直接互动,实际上 AI 也就难以获得真正的理解力和解决实际问题的能力。具身智能让 AI 能够通过感知和与真实环境交互来学习,这正是通往通用人工智能的关键路径。关于具身智能大模型的技术路线,很早之前我和王潜就开始了非常深度的探讨,也非常认同彼此的技术判断。

你们如何确定现在是做这件事的正确时刻?

王潜:2015 年前后,深度学习开始系统引入机器人领域特别是 manipulation 领域,当时大家是抱有很大的期望的,包括现在 Physical Intelligence 的 Sergey Levine 和我们走的端到端的路线,也包括其他人走的分层分步的路线,大家都觉得打破了之前的天花板之后,应该能直接取得类似当时在 CV 或者围棋上取得的那种很大的成功。

但到了 2018 年左右,情况比较清楚了:单纯靠深度网络 + 强化学习做不成 manipulation,核心问题还是在数据效率。

机器人的数据获取实在太难了,更关键的是数据需求随着任务复杂性的提升是指数级增长,就决定了像围棋或者图像识别那样解决机器人任务是不可行的。所以当时最主流的想法是大规模做 simulation 然后做 Sim2Real,我自己也在这个方向上探索了很长时间。但到了 2019 年,我的结论是从理论上来说,至少对 manipulation 这个领域,Sim2Real 的天花板是低而且难以突破的 —— 这条路线不 make sense。

今天各种公开的实验结果都能证明这个判断,但是当时,大家其实面临着除此以外无路可去的困境。我当时认为我们需要走类似当时 OpenAI 在走的路线。

后来,两个标志性事件发生了:谷歌 RT-1 和 ChatGPT。

谷歌 RT-1 的出现,可以说革新了机器人领域的研究范式。RT-1 的革命性有几点,第一是突破了之前占据主流的 RL(强化学习)+Sim2Real 范式所面临的明显的天花板,人类第一次看到了通用机器人的希望;第二是指出了机器人模型同样可能具有 Scaling Law,这一点在之后的 RT-X 中得到了确证。

但是机器人上即使出现了 Scaling Law,这条路是否能走到终点仍然是个巨大的问号,本质上还是因为机器人特有也是最困难的数据问题。2015 年做机器人的时候,大部分很好的工作都是几百几千条数据,对比之下,当时 CV 和 NLP 的数据量就在几百万、几千万这个数量级,处在那个时间点上,很难想象机器人面临的这个问题能够有类似 CV 和 NLP 领域的突破。

这个时候一锤定音的是 ChatGPT。在 ChatGPT 上我们第一次明确地看到了 In-Context Learning,或者可以叫 Zero-Shot Learning 的发生,当然之前也有逐渐出现 Fine-Tuning 和 Few-Shot Learning,但 In-Context Learning 是最终出现的极致,就是我们所谓的「涌现」。

尽管训练这样一个模型耗费的数据量很大,但有了这个基础模型之后,训练任何一个新任务的边际数据成本都被降低到极小。当我们考虑一个通用模型的时候,我们会发现我们第一次有了用有限的数据量做无限种类的任务的可能性,平均下来每个任务需要的数据量就会缩小到近乎无限小。这里的核心是统一模型带来的学习跨任务 Common Structure 的能力起到了至关重要的作用,而这件事在 OpenAI 做出结果之前没有得到过重视。

人们基于自身的经验,本能的会觉得把数据集中在一个领域做专家模型的效果会更好,但今天我们看到通才模型才是真正能够打破天花板,在相同投入下达到更高能力的正确路径。

在学术界能做这件事吗?

事实上,我们已经明显看到学术界落后于我们及美国其他 Startup 半年左右。这一点和曾经的 NLP 领域已经有些相似了。

学术界的导向过于偏重 Novelty 且缺乏工程化能力。机器人大模型一定是系统级创新和工程落地的结果。大到方向性的判断和投入,小到具体的技术框架的改进,这些事情非常重要;我们每天都在做相应的创新和优化。我们认为这个东西一定要以一个 Startup 的形式来做,且公司的创始核心团队本身需要具备学术前瞻性和工程化能力。

对于一家初创公司来说,实现「端到端通用机器人大模型」这个目标会很难吗?

首先感谢投资人们的支持:天使轮的时候,我们是在只有 idea 和技术的时候融到了钱;我们的商业计划书从大的技术方向和落地方向,从天使轮起就没有改过。我们后续融资也很顺利,一方面是因为我们的进展超过了预期;另一方面也得益于更多的机构认可我们。我们坚信,在正确的方向上,一定会汇集各方支持。

这可能是数百年来,中国第一次有机会在大产业上从零到一的阶段就领先世界,某种意义上也是历史的使命。在这个情况下,长期来看就一定还是在中国去做,可能要更好一点。

将人类从繁琐的体力劳动中解放出来

你们的目标是「将人类从繁琐的体力劳动中解放出来」,如何理解?

大家一直都说莫拉维克悖论,人们想的是 AI 能帮人们去做体力劳动等人不愿意做的事,然后人自己去写诗、画画。但实际上大家现在看到,AI 先做出来的是 AIGC 这些写诗画画的东西。反而物理世界的东西,人真正希望它帮忙做的事,AI 目前还难做到。

人和动物的区别是什么?一个是使用语言,一个是使用工具。语言上,GPT 已经某种意义上已经解决这个问题了;工具层面,就是我们要做的,让机器人能够脱离相对比较「笨」的状态。

自变量为什么选择了轮式机器人这种产品形式?人形机器人赛道的火爆,你怎么看待?

移动一个东西,你可以用底盘,也可以用很多其他方式,比如双足、四足。

我觉得底盘是最成熟的应用方式。综合考虑的话,要看具体场景究竟需要什么级别的通过性。我是觉得说人们日常生活中能接触到的大部分室内环境,轮式是足够的。

最关键的是成本,哪怕以后每种应用方式都非常成熟,我觉得成本永远都是一个大的问题。

那未来的话,你们会拿自己的技术去赋能其他家的产品?

会的,这是我们很重要的一个方向。

对于机器人大模型,五年到十年内会有一个什么样的趋势?

一般来说,人们特别容易低估中期的进展。我觉得可以把中期的,比如五年十年的想象力放大一些。在长一些的时间尺度上看,我们已经接近于我们希望实现的通用机器人了,我比大部分人都更加乐观一点。

关于未来具身智能的发展,这一代要解决的问题是通用性、泛化性以及处理复杂问题。我们希望行业能够持续良性发展。之前有一段时间,国内陷入卷视频 Demo 的浪潮,很多失真的 demo 视频中所展现的能力往往并不能代表背后的模型水平,其实这些很大程度上过度消耗了投资人及消费者的预期。

#字节豆包大模型

字节豆包大模型团队突破残差连接局限!预训练收敛最快加速80%

字节跳动豆包大模型团队于近日提出超连接(Hyper-Connections),一种简单有效的残差连接替代方案。面向残差连接的主要变体的局限问题,超连接可通过动态调整不同层之间的连接权重,解决梯度消失和表示崩溃(Representation Collapse)之间的权衡困境。在 Dense 模型和 MoE 模型预训练中,超连接方案展示出显著的性能提升效果,使收敛速度最高可加速 80%。

自从 ResNet 提出后,残差连接已成为深度学习模型的基础组成部分。其主要作用是 —— 缓解梯度消失问题,使得网络的训练更加稳定。

但是,现有残差连接变体在梯度消失和表示崩溃之间存在一种 “跷跷板式” 的权衡,无法同时解决。

为此,字节豆包大模型 Foundation 团队于近日提出超连接(Hyper-Connections),针对上述 “跷跷板式” 困境,实现了显著提升。

该方法适用于大规模语言模型(LLMs)的预训练,在面向 Dense 模型和 MoE 模型的实验中,展示了显著性能提升效果,使预训练收敛速度最高可加速 80%。

研究团队还发现,超连接在两个小型的视觉任务中表现同样优异,这表明,该方法在多个领域有广泛的应用前景。

- 论文标题:Hyper-Connections

- 论文链接:https://arxiv.org/pdf/2409.19606

1. 超连接的核心思想

前文提及,残差连接的两种主要变体 Pre-Norm 和 Post-Norm 各自都有其局限性,具体体现如下:

- Pre-Norm:在每个残差块之前进行归一化操作,可有效减少梯度消失问题。然而,Pre-Norm 在较深网络中容易导致表示崩溃,即深层隐藏表示过于相似,从而削弱了模型学习能力。

- Post-Norm:在残差块之后进行归一化操作,有助于减少表示崩溃问题,但也重新引入梯度消失问题。在 LLM 中,通常不会采用此方法。

超连接的核心思路在于 —— 引入可学习的深度连接(Depth-connections)和宽度连接(Width-connections)。

从理论上,这使得模型不仅能够动态调整不同层之间的连接强度,甚至能重新排列网络层次结构,弥补了残差连接在梯度消失和表示崩溃(Representation Collapse)之间的权衡困境。

深度连接与宽度连接

起初,该方法会将网络输入扩展为 n 个隐向量(n 称作 Expansion rate)。之后每一层的输入都会是 n 个隐向量,超连接会对这些隐向量建立以下两类连接:

- 深度连接(Depth-Connections):这些连接类似于残差连接,只为输入与输出之间的连接分配权重,允许网络学习不同层之间的连接强度。

- 宽度连接(Width-Connections):这些连接使得每一层多个隐藏向量之间可进行信息交换,从而提高模型表示能力。

静态与动态超连接

超连接可以是静态的,也可以是动态的。

其中,静态超连接(Static Hyper-Connections, SHC)意味着连接权重在训练结束后固定不变。而动态超连接(Dynamic Hyper-Connections, DHC)则对应连接权重可根据输入动态调整。实验表明,动态超连接效果更好。

2. 技术细节

超连接(Hyper-connections)

首先,考虑第 k 层的输入隐藏向量

,网络的初始输入为

,并将其复制 n 次,形成初始的超隐藏矩阵(Hyper Hidden Matrix):

这里,n 称为扩展率(Expansion Rate)。在第 k 层,输入是上一层的超隐藏矩阵

,即:

对最后一层的超隐藏矩阵逐行求和,得到所需的隐藏向量,并通过一个投影层输出网络最终的结果(在 Transformer 中即为归一化层和解嵌入层)。

为了简化后续分析的符号表示,作者省略层索引,直接将超隐藏矩阵表示为:

超连接可以用一个矩阵来表示,对于扩展率为 n 的情况,超连接矩阵 HC 如下:

考虑一层网络

![]()

,它可能是 Transformer 中的 attention 层或者是 FFN 层。超连接的输出

![]()

可以简单地表示为:

也就是说,用

作为权重对输入

进行加权求和,得到当前层的输入

:

同时,

用于将

![]()

映射到残差超隐藏矩阵

![]()

,表示如下:

最终的输出表达式为:

伪代码如下:

动态超连接的实现

超连接矩阵

![]()

的元素可以动态依赖于输入

![]()

,动态超连接的矩阵表示为:

同样,给定层

![]()

和输入

![]()

,可以得到动态超连接的输出:

在实际操作中,团队结合了静态和动态矩阵来实现动态超连接,动态参数通过线性变换获得。

为了稳定训练过程,团队在线性变换前引入归一化,并在其后应用 tanh 激活函数,通过一个可学习的小因子进行缩放。动态参数的计算公式如下:

实验表明,动态超连接在语言建模任务中优于静态超连接。

3. 为什么使用超连接(Hyper-Connections)

研究团队认为,残差连接的两种变体,即前归一化(Pre-Norm)和后归一化(Post-Norm),可以被视为不可训练的超连接。

随后,团队引入了顺序 - 并行二象性概念,展示了超连接如何动态优化层的排列以提升网络性能。

残差连接是不可训练的超连接

前归一化和后归一化的残差连接可以表示为以下扩展率为

![]()

的超连接矩阵:

其中,

![]()

和

![]()

分别表示神经网络层输入和输出的标准差,

![]()

表示它们之间的协方差。

对于 Pre-Norm,其超连接矩阵是一个

![]()

的矩阵,右下三角部分填充为 1,其余部分为占位符 0。对于 Post-Norm,权重依赖于输入和输出的方差及协方差,形成一个

![]()

的矩阵。因此,它们的超连接矩阵是不可训练的。

而本工作提出的方法的超连接矩阵是

矩阵,且权重是可训练的,甚至可以基于输入进行动态预测。

顺序 - 并行二象性

给定一系列神经网络模块,我们可以将它们顺序排列或并行排列。作者认为,超连接可以学习如何将这些层重新排列,形成顺序和并行配置的混合。

在不失一般性的情况下,可以将扩展率设置为 n=2。如果超连接以如下矩阵形式学习,神经网络将被顺序排列:

在这种情况下,深度连接退化为残差连接,如图 (a) 所示。

当奇数层和偶数层的超连接矩阵分别定义为以下形式时,神经网络每两层将被并行排列,类似于 Transformer 中的 parallel transformer block 的排列方式,如图 (b) 所示。

因此,通过学习不同形式的超连接矩阵,网络层的排列可以超越传统的顺序和并行配置,形成软混合甚至动态排列。对于静态超连接,网络中的层排列在训练后保持固定;而对于动态超连接,排列可以根据每个输入动态调整。

4. 实验结果

实验主要集中在大规模语言模型的预训练上,涵盖了 Dense 模型和 MoE 模型。

实验结果表明,使用超连接的模型显著优于使用残差连接的模型。

1B Dense 模型实验

只要扩展率 > 1,效果就十分显著,且训练更稳定,消掉了训练 loss 的 spikes。

7B Dense 模型实验

团队甚至 Scale 到了 7B 模型,效果也十分亮眼,同时可以看到有超连接的网络训练更稳定。

7B 候选激活 1.3B 的 MoE 模型实验

可以看到,下游指标全涨,在 ARC-Challenge 上甚至涨了 6 个百分点。

综上,研究团队介绍了超连接(Hyper-Connections),它解决了残差连接在梯度消失和表示崩溃之间的权衡问题。实验结果表明,超连接在大规模语言模型的预训练以及视觉任务中都表现出显著的性能提升。

值得注意的是,超连接的引入几乎不增加额外的计算开销或参数量,团队认为,该成果具有广泛的应用潜力,可以推广到文音视图模态的不同任务上,包括多模态理解、生成基座模型等。

5. 写在最后

团队关注底层问题,尤其在 LLMs 和多模态方面,期望实现更多突破。

#TableGPT2

结构化表格也成模态!浙大TableGPT2开源,最强表格AI问世

当结构化数据也变成一个模态,哪家的大语言模型能脱颖而出呢?

现在正是多模态大模型的时代,图像、视频、音频、3D、甚至气象运动都在纷纷与大型语言模型的原生文本模态组合。而浙江大学及其计算机创新技术研究院的一个数十人团队也将结构化数据(包括数据库、数仓、表格、json 等)视为了一种独立模态。

基于这一视角,依托 Qwen,他们研发了 TableGPT 系列模型。现如今,这个模型已经更新到了第 2 代,性能表现较之前代已有大幅提升:在某些基准上,TableGPT2 能够媲美甚至优于 GPT-4o!或者按团队负责人陈刚和赵俊博两位教授的说法:「目前通用大模型在许多结构化数据相关的任务上的表现仍然较弱,TableGPT2 在相关任务的榜单上铁腕刷榜 —— 各类相关任务刷出去平均 40 个点。」

- 论文标题:TableGPT2: A Large Multimodal Model with Tabular Data Integration

- 论文地址:https://arxiv.org/pdf/2411.02059

- TableGPT 智能体:https://github.com/tablegpt/tablegpt-agent

- Hugging Face:https://huggingface.co/tablegpt/TableGPT2-7B

该团队表示:「提出 TableGPT2 的关键动机是解决当前 LLM 在数据驱动型真实世界应用中的限制。」

当今的许多 LLM 的设计目标就是以端到端的方式运行,而没有整合外部数据。但该团队认为这种方法存在固有缺陷。举个例子,如果你想用 LLM 来帮助你挑选股票,但如果不给它提供实时的市场信息,它的建议就根本不可能靠谱;更别说必需病人病历和各类过往的指标数据才能做出准确判断的医疗 AI 应用了。具身智能中的灵巧手的触觉信号以及多个传感器中的各类 「觉」 也都是结构化信息。

同时,即便 LLM 已经整合了外部数据源(如数据库),其性能也往往无法达到最优。目前常见的整合思路包括通过工具(如 natural-language-to-sql / NL2SQL)来调用外部数据源以及通过更长的长下文和新架构来纳入外部数据源。但这些方法要么难以用于复杂场景,要么就效率低下,不实用。

基于这些思考,该团队认为在整合外部数据源时需要根本上的范式转变。TableGPT2 也由此而生,该模型的设计目标是直接且高效地整合和处理表格数据,克服当前 LLM 的固有限制,进而实现生产级部署。

之前 LLM 和 VLM 方面的研究已经证明了大规模多样化数据集的重要性。其实表格数据也同样多,并且也同样重要。据估计,全球超过 70% 的数据都是以结构化的表格形式存储的,包括数据库和电子表格。

所以,资源浩瀚,也因此,开发大规模表格模型极具潜力!该团队表示:「通过使用大规模表格及其 schema 元数据的数据集,我们的目标是探索能否有效地建模这些数据格式,从而得到可用于商业智能等应用的功能强大的模型。」

TableGPT2 的表格数据编码器是该团队全新设计的,其重在建模表格数据的结构和内容。这让 TableGPT2 可以捕获 schema 层面和单元格层面的信息,从而有望为表格大模型带来文本模型和视觉模型所经历过的那种巨大提升。

TableGPT2 是什么

从名称也能看出,TableGPT2 是 TableGPT 的新一代版本。初始版本的 TableGPT 就已经引入了结构化特定领域语言(DSL)和专用表格编码器等方法,可以管理复杂的基于表格的查询。在此基础上,TableGPT2 实现了巨大的改进。他们不仅扩大了数据和训练协议的规模,还重新设计了每个组件,同时也引入了一些提升稳健性、扩大适用性以及优化商业智能应用性能的技术。

最终,大规模多模态模型 TableGPT2 诞生了!它有两种配置:7B 和 72B 版本。它们全都基于 Qwen2.5 系列模型。训练过程中,该团队使用了超过 860 亿 token 来进行持续预训练(CPT)、超过 43.75 万个表格 - 语言交织的样本来训练编码器、236 万多个高质量「查询 - 表格 - 输出」元组来进行监督式微调。

在相关研究中,这种规模是前所未有的,足以保证 TableGPT2 满足涉及结构化或表格数据的现代应用的严格要求。

TableGPT2 经历的持续预训练(CPT)、监督式微调(SFT)和支持生产级能力的智能体框架不同于传统 LLM,因为这里的预训练和微调更加注重编程、多轮推理和工具使用。这些特点可确保模型不仅擅长自然语言处理,而且能够很好地处理与表格相关的复杂任务。

此外,该团队还初步探索了表格数据的多模态对齐。具体来说,TableGPT2 创新性地加入了一个单独的模态模块,专门用于读取和解释表格数据。类似于视觉 - 语言模型(VLM),TableGPT2 包含一个表格数据读取模块,其作用是生成与来自文本输入的 token 嵌入相连接的专用嵌入。这个新增模块可让 TableGPT2 更好地捕获表格数据的结构和语义,从而在复杂的商业智能场景中实现更准确的表格理解。图 1 描绘了其整体模型框架。

TableGPT2 是如何炼成的

持续预训练

为了实现 TableGPT2 的目标,该团队首先是通过持续预训练(CPT)来提升模型的编程和推理能力。

具体来说,80% 的 CPT 数据都是标注良好的代码,从而确保 TableGPT2 具有稳健的编程能力,这与 DeepSeek-v2 采用的方法是一致的。此外,该团队还做了补充;他们收集整理了大量包含多种领域知识(如金融、制造业、生物技术、市场技术)的推理数据和一般教科书,以保持数据比例平衡,增强推理能力。表 1 展示 CPT 过程中使用的数据分布和总 token 数。

在数据处理方面,他们采用了一种两级过滤策略。

在文档层面,他们使用 54 个不同的类别对数据进行了标注,以确保全面覆盖不同的文档类型。下表展示了一些重要的过滤标签。

在 token 层面,则是利用了 RHO-1 来微调对高质量 token 的选择。

此外,他们还引入了一种可将代码长度和上下文窗口设置纳入考虑的新方法,这可优化模型有效处理多种不同代码段的能力。

经过彻底过滤后,最终的 CPT 数据包含 86B token,这种稳健强大的预训练可确保 TableGPT2 具备必要的编程和推理能力,足以应对复杂的商业智能和其他相关任务。

有监督微调

在 TableGPT2 中,监督式微调(SFT)的作用是解决在用于商业智能任务和场景时的局限。

为此,该团队编排了一个数据集,其中包含范围广泛的近乎现实的关键场景,包括多轮对话、复杂推理、工具使用和针对具体业务的查询。

这个数据集的构建过程既包括人工标注,也包含一个专家驱动的自动化标注流程,从而可以保证数据的质量和相关性。总体而言,SFT 过程涉及 236 万个样本, token 数量达数十亿,足可用于进一步微调模型,使其满足商业智能和其他涉及表格的环境的特定需求。

更具体地说,TableGPT2 的 SFT 流程有一个关键差异,即这 236 万个指令样本的组成非常平衡且多样化。如此一来,就可以满足表格相关任务的需求:既需要通用的模型能力,也需要针对表格的技能。

该数据集包含的表格专有任务包括代码生成(Python 和 SQL)、表格查询、数据可视化、统计测试和预测建模。此外,其中还有表格理解、表格生成、缺失值插补和基于表格的问答等多种任务,几乎涵盖了表格使用的所有阶段。输入格式加上随机排列的表格元数据(如字段描述、schema 信息和值枚举),可以产生超过 20 种不同的「表格 - 信息」输入组合,组可确保全面覆盖。

为了保证数据质量,他们还实施了一个多步骤的数据过滤流程:

- 首先,使用一组基于规则的过滤器,包括使用 Python 和 SQL 执行器检查代码的可执行性和正确性,从而消除常见错误(例如键错误和类型转换问题)。此外,还会使用正则表达式和其他规则来丢弃异常输出。

- 然后,使用多个模型(如 GPT-4o)对过滤后的数据进行评分;这里使用的提示词是专门设计的,可以保证得到更为细致的评估。只要当样本在所有评分组合上都超过阈值时,该样本才会被保留下来。

- 之后,通过人工检查进行样本校准。如果样本准确率低于 95%,就重新审查并优化其数据生成和过滤脚本。

- 最后,执行评估,这会用到一个包含约 94.9K 个案例(包括现有案例和新构建的案例)的固定验证集,如此可确保生成的结果是可执行且准确的。同时还会执行进一步的手动验证来抽查任何不一致之处并检测潜在的数据问题,例如缺少函数调用或多轮对话能力较差。

用于表格数据的数据增强

为了提升 TableGPT2 的性能(尤其是商业智能任务性能),该团队采用了多种查询增强技术,包括

- 在查询内引入字段时进行模糊化处理

- 通过匿名化字段名和类别值来实现表格数据增强

- 通过结合单轮和多轮问答任务来增强模型的多功能性

- 使用变动的提示词格式和输出结构来降低 TableGPT2 对某些提示词模板的敏感度

- 在数据生成过程中应用后处理增强来提升训练数据的多样性

语义表格编码器

由于 NL2SQL 等传统工作流程存在局限性,该团队为 TableGPT2 设计了新的语义编码器。

这种新的表格编码器的输入是整张表格。基于此,它可为每一列生成一组紧凑的嵌入。

该架构是根据表格数据的独特属性专门设计的,毕竟表格与文本、图像和其它数据类型存在根本性差异。

表格的语义来自四个关键维度:单元格、行、列和表格整体结构。这些维度都存在排列不变性(permutation invariance)。基于这一观察,该团队实现了一个没有位置嵌入的二维注意力机制以及一个分层特征提取过程。这能确保行方向和列方向的关系都被捕获并被有效理解。

此外,他们还采用了一种逐列式对比学习方法,以鼓励模型学习有意义的、对结构有感知的表格语义表征。

该团队使用了 Q-former 式的适应器(配备了一组可学习的查询)来将列嵌入与文本嵌入对齐。

他们还引入了两个特殊 token <tab> 和 </tab>,以区分表格特征和原生文本,让模型可以同时处理这两种模态,并且不产生混淆。

为进一步增强文本信息、列嵌入和 schema 元数据之间的对齐程度,他们还使用了联合指令微调。此过程有助于优化模型对表格数据的理解,使其能够更有效地集成和解读各种输入。

顺带一提,目前这个编码器部分还尚未开源。至于原因,赵俊博博士表示:「一方面保护下团队学生们未来的小论文,另外一方面确实 VLM 和特定领域的适配没弄好,解码器可以独立使用,效果仍在。」

智能体框架

该团队在开源库中提供了一个全面的智能体工作流程运行时间框架,其设计目标是将 TableGPT2 无缝地集成到企业级数据分析工具中。该框架包含三个核心组件:

- 运行时间的提示词工程

- 一个安全的代码沙箱

- 一个智能体评估模块

它们加在一起,可以提升智能体的能力和可靠性。这个工作流程具有模块化的步骤,因此可支持复杂的数据分析。这些步骤包括输入规范化、智能体执行(可选择 VLM 支持)、工具调用。

再结合检索增强式生成(RAG,用于高效上下文检索)和代码沙箱(用于安全执行),该框架可确保 TableGPT2 为实际问题提供准确、与上下文相关的见解。

下图展示了智能体的完整工作流程:首先通过一个提示词工程模块来准备和处理输入查询。再基于一个外部知识库使用 RAG 模块后,将经过处理的输入送入主模型。然后,TableGPT2 会与一个视觉 - 语言模型(VLM)合作生成工具调用、代码等相关动作。通过观察中间结果,可以根据需求选择是否迭代,以利用该智能体的反思能力。通过智能体与工具之间的无缝交互,这个迭代过程最终可得到最终输出。

TableGPT2 效果怎么样

在实验部分,团队此次针对表格相关任务进行了全面的基准测试,不仅涵盖了已有的一些数据集,还加入了一个新收集的、面向真实任务的复杂表格数据集,从而提供了一个严格的评估平台。

为了进行全面的比较,团队选择了多样化的基线大语言模型。第一类是最先进的开源通用 LLM,包括 DeepSeek-Coder-V2-Lite-16B、 YiCoder-9B-Chat 以及 Qwen2.5-Coder-7B-Instruct、Qwen2.5-7B-Instruct。

第二类是针对表格相关任务进行微调或专门开发的模型,比如针对表格分析设计和优化的 TableLLM、为处理电子表格和文档设置中各种真实表格操作而微调的 CodeLlama-13B。

基准概览

下表 4 汇总了现有的表格理解和推理基准,共涵盖了 27.7K 个表格和 88.9K 个测试样本。团队将这些基准划分为了以下 6 项主要的表格分析任务,以全方位评估模型在不同类型任务中的性能:

- 表格理解

- 表格问答(TableQA)

- 表格事实验证

- 表格到文本生成(Table2Text)

- 自然语言到 SQL(NL2SQL)

- 整体评估

除了表 4 中已有的基准,团队构建了一个新基准 RealTabBench。现有基准大多侧重于简单的任务,不符合实际使用场景。为了克服这一局限性,团队构建了这个更具挑战性、更能反映实际应用场景的新基准,从商业智能(BI)场景中的真实表格中收集了 360 个复杂数据表格,并在此基础上制定了 6000 个真实、复杂的查询语句。

在评估模型性能时,团队采用了两个在实际应用中特别难处理的表格特征,分别是:

- 模糊性,表格中潜在的形似「A1」、「A2」等难以确认实际含义的匿名字段会对自动分析构成很大的挑战;

- 不规则性,在生产环境中,表格数据通过包含普遍的合并操作和不规则的结构,比如合并单元格和非均匀布局。

同时,针对新基准 RealTabBench,团队又从三个关键维度对生成的结果进行了评估,即一致性、信息完整性和安全性。

为了保证权威性,团队采用人工评审员与评估 LLM 结合的混合系统来生成最终的分数,并已经公开了整个评估流程中的部分样本。

- 项目地址:https://github.com/tablegpt/tablegpt-agent/tree/main/realtabbench

评估结果

下表 5 展示了 TableGPT2 (7B 和 72B 版本)与最先进基线模型的比较结果。值得注意的是,在没有对任何特定基准训练集进行大量训练的情况下,TableGPT2 显著优于几乎所有其他 LLM 方法。并且在某些基准上,TableGPT2 能够媲美甚至优于 GPT-4o。

另外,在涉及分层结构表格的复杂数据基准(如 HiTab)上,当前大多数 LLM 方法表现不佳。相反,TableGPT2 有了明显改进,与 Qwen2.5 系列模型相比,执行准确率实现了 60% 以上的绝对增长。

同样地,对于 RealTabBench 数据集,TableGPT2(7B)在多项任务上均达到了新 SOTA。

为了更直观地展示 TableGPT2 的效果,团队选择了几个比较案例(vs Qwen2.5 系列模型),涵盖了不规则表格、一般表格和模糊表格的场景。具体结果如下图 4 所示。

最后,针对表格相关任务对 LLM 微调不应损害其整体性能。为了验证这一观点,团队在下表 7 中对流行的基准展开评估,包括 MBPP、HumanEval、CMMLU 和 MMLU。

结果显示,TableGPT2 在这些基准上保持了强大的性能,并没有出现通用能力的下降。

未来改进方向

不过,团队也表示,尽管 TableGPT2 在评估中实现了 SOTA,但尚未完全解决在实际 BI 环境中部署 LLM 的挑战。因此距离将该模型可靠地用于生产系统仍有一些差距。团队提出可以采用以下几种关键的技术与方法来解决。

一是针对特定领域进行编码。

团队虽然利用 Python 和 SQL 数据对 TableGPT2 进行了微调,但考虑到安全和效率等因素,特定领域通常需要专门的编码。这就面临一个关键挑战:如何使 LLM 能够快速适应企业特定的 DSL 或伪代码?拿 TableGPT2 来说,虽然它可以生成代码,但问题在于如何有效地弥合这些代码与企业数据基础设施特定需求之间的差距?

在 TableGPT2 中,团队采用了一种混合输出方法,结合使用了结构 DSL 输出和标准编程代码。这使得模型流畅地生成结构化和非结构化代码,在提供灵活性的同时可以保持领域特定应用所需的结构。

这些领域特定语言可以提供更好的可解释性,允许通过用户友好的界面更直接地与 LLM 输出进行交互。同时,这些语言可以最大限度地减少潜在的安全风险和错误,从而带来更安全、更强大的解决方案。

团队认为,生产环境中的编码不单单是简单的代码生成,需要仔细考虑领域特定的需求、基础设施兼容性以及灵活性与安全性之间的平衡,在混合使用 DSL 和通用代码时更要如此。

二是多智能体设计。

尽管 TableGPT2 在表格相关任务中取得了 SOTA 性能,但仍然不能指望单个端到端 LLM 能够独立地完全解决复杂的真实任务。因此,团队最近在密切关注一项新的研究 —— 自动化智能体系统设计,它遵循了 LLM 工作流的自动化编排原则。

其中多个 LLM 被组织成有向无环图(DAG)结构,这样输入查询可以根据图的拓扑顺序自动路由到一系列 LLM 中。每个 LLM 执行一项专门的功能。DAG 流程由系统本身决定,并根据手头任务决定要用到哪些 LLM。这种自动化流程工程创建了一个灵活的模块化工作流程,并根据问题需求动态调整,正如 AutoML 系统自动配置机器学习模型以获得最佳性能一样。

这样的例子还有很多,比如用于股票和基金推荐的小型自然语言应用,它需要将 LLM 与实时市场数据连接起来。在这种多智能体架构中,通常需要为不同的 LLM 分配不同的角色,每个 LLM 都要在针对其功能专门定制的数据上进行微调。每个 LLM 还要根据输入来配置不同的提示词模版和 RAG 设置,并在输出阶段应用不同的编码和对话逻辑。这样一来,每个阶段的定制微调可以确保整个 pipeline 提供精准和上下文感知的响应,从而解决真实应用的复杂性。

一个足够先进的单一基础模型最终能不能取代链接多个模型的需要呢?团队认为这在很大程度上仍是理论上可行。这种模型需要拥有足够的通用智能来处理统一框架内的各种任务。但从自身经验出发,团队表示通常需要两个以上的 LLM 才能解决真实应用的全部复杂性。因此,团队认为,单一模型何时能够熟练、无缝地解决跨多个领域的问题仍不确定,在生产阶段尤为如此。

三是充分利用表格的多功能性。

尽管 TableGPT2 主要关注 BI 应用 —— 在这些应用中,结构化数据的上游来源是数据库或数据仓库;不过,表格数据还有另一个非常常见的来源,即 Apple Pages 或 Microsoft Excel 等应用程序。

这些表格与数据库等基础设施中的表格往往差异巨大,因为人们日常使用的表格常常并不规则。举个例子,Pages 或 Excel 中的表格常常有合并单元格、不一致的行列结构、非标准的数据格式。这些不规则会让此类表格的处理复杂度更高。另外,不同组织机构使用的表格形式差异也很大,比如有些单元格可能会包含自由形式的文本、有些单元格没有填充等等。

在 TableGPT2 模型所在的智能体工作流程中,该团队还专门为规范不规则表格微调了一个单独的 LLM,并将其集成到一个整体系统中。然而,处理不规则表格仍有很大的改进空间,尤其是考虑到其巨大的商业生产潜力。

因此,该团队猜想,要处理这种不规范,就应该从预训练阶段开始,以确保模型能够熟练处理表格的各种格式。

当前的许多 LLM 以及 RAG 过程都无法充分地处理这些非标准表格结构。此外,许多现有的语料库也常常忽视这类数据。这一有待填补的空白是值得研究者未来探索的宝贵机会。

#价值万亿的具身智能市场,大佬们如何从世界模型下刀?

具身智能,简单来说,就是赋予 AI 一个「身体」,让这颗聪明的大脑在物理世界中行动自如。

把这颗大脑升级成世界模型 —— 它拥有记忆、直觉和常识时,机器人可以不再机械地按训练行事,而是能够灵活变通,具体问题具体分析。

于是,在这两个火热的概念齐头并进之时,这样的展示层出不穷,机器人为你扫地、喂猫、铺床、做饭,以后养老不用愁,放心交给机器人就好了。

但是为什么我们身边还没见到一个这样的机器人呢?

带着这个问题,我们围观了今年的智源论坛 2024 具身与世界模型专题峰会。当前学界前沿最聚焦具身智能的哪些问题?如何让大模型飞升的 scaling law,在机器人领域也获得回响?我们距离真正的世界模型,还有多远?

从前沿技术成果,到最新实践应用,来自学术界和产业界的代表们的精彩分享贯穿全天。

大佬们具体都聊了什么?重点都已经划出来了!

欢迎查看直播回放:https://event.baai.ac.cn/activities/855

Scaling Law 的成功,机器人也想复刻

参数量越大,模型性能越高,这一原则在大模型领域已经得到了充分验证。如何在机器人领域,活用「Scaling Law」的公式,这是产业面临的共性问题。

作为人工智能的创新引领者,联合产学研协同突破行业痛点,也是智源研究院一直以来的核心愿景。

一开场,智源研究院院长王仲远详细介绍了智源大模型「全家桶」。其中,最引人瞩目的要数首个原生多模态大模型 Emu3。

它可以融会贯通文本、图像、视频三种模态,也首次证明了 Scaling Law 在多模态大模型的可行性。

如何让 scaling law 跨越不同任务、本体、场景,构建泛化超强能力的大模型?这是智源具身多模态大模型研究中心负责人仉尚航近来关心的问题。在此次分享中,她展示了一系列基础模型的新成果。

人类在思考问题时有快慢之分 —— 既有脱口而出的「快思维」,也有静心推理的「慢思维」。

受此启发,她带领研究团队提出了 RoboMamba、MR-MLLM 等一系列多模态大模型。详情可以参考报道:《北大推出全新机器人多模态大模型!面向通用和机器人场景的高效推理和操作》。

在打破模态的突破之上,仉尚航的下一步是把模态的原生能力升维到 4D—— 构建更好的 4D 世界模型与数据集。

4D 世界模型 EVA

- 论文链接:https://arxiv.org/pdf/2410.15461

「具身智能最大的问题就是没有数据」,那么什么样的数据对机器人最有用呢?

爆火全网的 Aloha、特斯拉的 Optimus 系列都在推崇遥感操作收集的真人数据,Depth Anything 这样的单目视觉方法也在业界流行。

而北京大学助理教授、银河通用创始人,智源学者王鹤认为,合成数据或许是更优解。

这一结论来自他们的研究成果 D3RoMa。红外深度图显示,D3RoMa 渲染出的光斑与真实世界高度吻合,首次实现了亚厘米级的深度精度。

- 论文链接:https://arxiv.org/pdf/2409.14365

至于机器人数据的 next level,王鹤看好的是 4D 数据。

提到 scaling law 在机器人领域的里程碑,绕不开「机器人的 ImageNet 时刻」—— 谷歌 DeepMind 联合其他机构推出了 Open X-Embodiment 数据集,训练出了能力更强的 RT-X 模型。

智源研究院还特邀了谷歌 RT-1 和 RT-2 的作者 Ted Xiao 带来分享。

Ted Xiao 回顾了 scaling law 如何在 RT-1 和 RT-2 的逐步生效。而最近与 o1 一起爆红的思维链,或许也能带给机器人领域新的启发。

Ted Xiao 介绍了 RT-Hierarchy 策略。机器人执行任务之前,会先生成一个「语言运动查询」,用于预测一些粗粒度的动作,比如「向前移动手臂」。随后,系统会生成一个具体的「动作查询」,将动作分解为更细致的步骤。

有时候,机器人并不知道自己在做什么

「有的时候,机器人并不知道自己在做什么。」这可能是这场峰会被反复 cue 到的一句话。

清华大学自动化系教授,加速进化联合创始人赵明国展示了一场精彩的机器人足球赛。踢足球是一项天然的具身智能任务,机器人需要判断球的位置,并协调下一步的动作。从上世纪 90 年代开始,日本本田开启了提升机械腿自主行走能力的探索。

尽管机器人的运动策略经历了一代又一代的技术革新,但在今年的 RoboCup 上,我们仍然看到了这样的一幕:面对空无一人的球门,即使足球已经压在门线上,出战的机器人选手却做不出判断:要不要补上决定性的临门一脚呢?

要使机器人在行为层面展现出真正的智能,赵明国认为关键在于根据不同身体部位的功能分工来设计和训练机器人。如果一个机器人能够掌握手部的典型任务,如抓取和放置物体,腿部的踢球,以及需全身协调的骑自行车等任务,逐步攻克,最终将这些能力扩展到实际应用中。

同样提出这个问题的还有星尘智能的创始人兼 CEO 来杰。在开发机器人的过程中,他发现,虽然大语言模型为机器人提供了很多知识,但这些知识离世界的底层逻辑还很远。

例如,机器人已经从无数次训练中熟练地掌握了开瓶盖技巧,但如果递给它一瓶横放的矿泉水,它不会像人类一样下意识地先将瓶子竖直,而是直接打开,水都洒了出来。

世界模型可以补全机器人感知中缺少的这些细节和背景信息。在等待世界模型的开花结果的过程中,星尘智能把目标设定为 Design for AI,机器人平台将作为中间态,为世界模型提供丰富的数据支持。而当世界模型最终成熟的时候,就要做最好的终端。

吉林大学唐敖庆讲席教授、曼彻斯特大学终身教授任雷则带来了一种不需要动脑,仅凭「肌肉记忆」,机器人就能自主行动的全新方案。

他带领研究团队结合神经解剖学和生理学,深入纳米级别,解码人类的触觉感知与运动神经控制机理,提出了仿生拉压体机器人机制。

即使在 X 光的透视下,仿生拉压体机器人几乎完全重现了人体自然行走的三维步态。相比波士顿动力采用的动力系统,机器人花费的能耗也降低了一个数量级。

中国科学院计算技术研究所研究员蒋树强从涉身性、交互性和情境性等维度,结合哲学视角,对具身智能这一概念进行了深入分析和定位。

机器人进厂打工,走到哪一步了?

乐聚机器人创始人冷晓琨分享了人形机器人产业的一线视角,「虽然比不上造车,但工业场景对人形机器人的需求已经足够支撑一个新的产业。」

乐聚机器人也正在科研平台、商业服务 、工业流水线、家庭康养、城市巡逻等各种场景中发光发热。其中,最多的订单对标展厅导览、导购的岗位。

无需长期培训,也不会频繁跳槽的人形机器人,可以节省高达 60% 的成本投入。

要让机器人坐在流水线上打螺丝,达到熟练工人的装配水平,触觉感知至关重要。没有触觉感知,机器人很难掌握螺栓应该拧到什么程度。

大湾区大学 (筹) 讲席教授,先进工程学院院长王煜认为,人形机器人产业化的关键在于让触觉信息转化为运动信号,让机器人能真正地得心应手。

当前,王煜团队在高动态触觉传感器领域的一系列突破,正为这一目标按下「加速键」。

面对工厂中复杂的任务,一双灵巧手亦不可或缺。中科院自动化所研究员王鹏及其团队注意到,人类手部之所以能够完成各种复杂的操作任务,很大程度上得益于其高度的灵活性和对环境的适应性。

于是,在设计通用灵巧操作具身智能体系 Casia Hand 系列时,他们特别注重强调柔顺性与刚性的结合,确保机器人在执行任务时既能保持稳定,又能避免对目标物体造成损伤。

One more thing

相较于传统 AI 三要素数据、算法、算力,具身智能在硬件这一新要素上了有了更多要求。以上四要素的协同进化,推动了具身智能的新范式变革。

在圆桌讨论中,智源研究院副院长林咏华也向嘉宾们提出了一个问题:「从硬件、数据、算法、芯片四个方面,哪个对搭载具身智能的机器人最重要?」

尽管每个要素都面临着无数等待探索的问题和挑战,但数据显得尤为迫切,智源研究院呼吁构建一个开放、标准化、低成本且便于复制的数据平台。

作为即将突破万亿规模的市场,具身智能的年复合增长率已达到 20.7%。在这火热的浪潮中,学术界和工业界,都需要更多像智源峰会这样的交流与讨论,也需要更多冷静的观察与深思。

#OpenAI o1强推理能提升安全性

长对话诱导干翻o1

本文作者来自于上海交大,上海 AI Lab 和北航。第一作者是上海交大博士生任麒冰,导师为马利庄教授,其他作者包括北航研究生李昊,上海 AI Lab 研究员刘东瑞,上海 AI Lab 青年科学家邵婧等。

最近,以 OpenAI o1 为代表的 AI 大模型的推理能力得到了极大提升,在代码、数学的评估上取得了令人惊讶的效果。OpenAI 声称,推理可以让模型更好的遵守安全政策,是提升模型安全的新路径。

然而,推理能力的提升真的能解决安全问题吗?推理能力越强,模型的安全性会越好吗?近日,上海交大和上海人工智能实验室的一篇论文提出了质疑。

这篇题为《Derail Yourself: Multi-turn LLM Attack through Self-discovered Clues》的论文揭示了 AI 大模型在多轮对话场景下的安全风险,并开源了第一个多轮安全对齐数据集。

- 论文地址:https://arxiv.org/abs/2410.10700

- 多轮安全对齐数据:https://huggingface.co/datasets/SafeMTData/SafeMTData

- 代码开源:https://github.com/renqibing/ActorAttack

这项研究是怎么得到上述结论的呢?我们先来看一个例子。

假设一个坏人想要询问「如何制作炸弹」,直接询问会得到 AI 的拒绝回答。然而,如果选择从一个人物的生平问起(比如 Ted Kaczynski,他是一个制作炸弹的恐怖分子),AI 会主动提及他制作炸弹的经历。在接下来的问题里,用户诱导 AI 根据其之前的回答提供更多制作炸弹的细节。尽管所有的问题都没有暴露用户的有害意图,用户最终还是获得了制作炸弹的知识。

当详细查看 OpenAI o1 的「想法」时,研究人员惊奇地发现,o1 在开始的推理中确实识别到了用户的有害意图,并且声称要遵守安全政策。但是在随后的推理中,o1 开始暴露了它的「危险想法」!它在想法中列举了 Kaczynski 使用的策略和方法。最后 o1 在回答中详细给出了制作炸弹的步骤,甚至教你如何增加爆炸物的威力!研究人员的方法在 Harmbench 上对 o1 的攻击成功率达到了 60%,推理能力带来的安全提升在多轮攻击面前「失效」了。

除了「Ted Kaczynski」,和炸弹相关的人和物还有很多,这些都可以被用作攻击线索,坏人可以把有害意图隐藏在对相关的人和物的无害提问中来完成攻击。为了全面且高效地去挖掘这些攻击线索,研究人员设计了多轮攻击算法 ActorAttack。受拉图尔的行动者网络理论启发,研究人员构建了一个概念网络,每个节点代表了不同类别的攻击线索。研究人员进一步提出利用大模型的先验知识来初始化网络,以自动化地发现攻击线索。在危险问题评测集 Harmbench 上的实验结果表明,ActorAttack 在 Llama、Claude、GPT 等大模型上都取得了 80% 左右的攻击成功率。

最后,研究人员基于 ActorAttack 开源了第一个多轮对话安全对齐数据集。使用多轮对话数据集微调的 AI,极大提升了其应对多轮攻击的鲁棒性。

社科理论启发的安全视角

ActorAttack 的核心思想是受拉图尔的「行动者 - 网络理论」启发的。研究人员认为,有害事物并非孤立存在,它们背后隐藏着一个巨大的网络结构,技术、人、文化等都是这个复杂网络中的节点(行动者),对有害事物产生影响。这些节点是潜在的攻击线索,研究人员通过将有害意图隐藏在对网络节点的「无害」询问中,可以逐渐诱导模型越狱。

自动大规模的发现攻击线索

具体来说,ActorAttack 的攻击流程分为「Pre-attack」和「In-attack」两个阶段。在「Pre-attack」阶段,研究人员利用大语言模型的知识构建网络,发掘潜在的攻击线索。在「In-attack」阶段,研究人员基于已发现的攻击线索推测攻击链,并逐步描绘如何一步步误导模型。随后,研究人员按照这一攻击链生成多轮询问,从而实施攻击。

为了系统性地挖掘这些攻击线索,研究人员根据节点对有害对象产生影响的方式不同,提出了六类不同的节点(比如例子中的 Ted Kaczynski 在制造炸弹方面属于「执行(Execution)」节点)。每个节点包括人物和非人物(如书籍、媒体新闻、社会活动等)两种类型。研究人员利用大模型的先验知识,自动化地大规模发现网络节点。每个网络节点均可作为攻击线索,从而形成多样化的攻击路径。

ActorAttack 实现了更高效和多样的攻击

首先,研究人员选取了五类代表性的单轮攻击方法作为比较基准,在 Harmbench 上的实验结果表明,ActorAttack 相比于单轮攻击方法,实现了最优的攻击成功率。

接着,研究人员选择了一个强大的多轮攻击方法 Crescendo 进行比较,为了衡量多样性,研究人员对每个多轮攻击独立运行了三次,计算它们之间的余弦相似度。下图展示了在 GPT-4o 和 Claude-3.5-sonnet 上不同攻击预算下,每个方法的攻击成功率和多样性。研究人员发现 ActotAttack 在不同攻击预算下,其高效性和多样性两个指标均优于 baseline 方法。

ActorAttack 可以根据不同的节点生成多样的攻击路径,其好处之一是相比于单次攻击,它可以从不同的路径中找到更优路径,生成更高质量的攻击。为了从经验上分析,研究人员采用了不同数量的节点,并记录所有的节点中攻击效果最好的得分。实验结果表明,得分为 5 分(最高分)的攻击比例随着节点数量的增多逐渐增加,验证了 ActorAttack 的优势。

ActorAttack 生成的多轮提问可以绕过基于 LLM 的输入检测器。为了验证 ActorAttack 隐藏有害意图的有效性,研究人员利用 Llama Guard 2 分类由单轮提问、ActorAttack 生成的多轮提问,以及 Crescendo 生成的多轮提问是否安全。Llama Guard 2 会输出提问为不安全的概率。实验结果显示,ActorAttack 生成的多轮提问的毒性比直接提问和 Cresendo 的多轮提问更低,揭示了其攻击的隐蔽性。

第一个多轮对话场景下的安全对齐数据集

为了缓解 AI 大模型在多轮对话场景下的安全风险,研究人员基于 ActorAttack 构造了第一个多轮对话安全对齐数据集。一个关键问题是决定在多轮对话中插入拒绝回复的位置。正如文中开头展示的例子那样,ActorAttack 在中间的询问就可以诱导出模型的有害回复,即使没有完全满足用户意图,这样的回复也可能被滥用,因此研究人员提出使用 Judge 模型定位到第一个出现有害回复的提问位置,并插入拒绝回复。

实验结果展示,使用研究人员构造的多轮对话数据集微调 Llama-3-8B-instruct 极大提升了其应对多轮攻击的鲁棒性。研究人员还发现安全和有用性的权衡关系,并表示将缓解这一权衡作为未来工作。

展望

本片工作揭示了 AI 大模型在多轮对话场景下面临的安全风险,甚至对有强推理能力的 OpenAI o1 也是如此。如何让 AI 大模型在多轮长对话中也能保持安全意识成为了一个重要问题。研究人员基于 ActorAttack,构造出了高质量的多轮对话安全对齐数据,大幅提升了 AI 模型应对多轮攻击的鲁棒性,为提升人机交互的安全可信迈出了坚实的一步。